Teil 2 der RAG-Studienreihe: Strukturierte Daten und intelligente Chunking-Strategien für RAG-Systeme

Einleitung

Retrieval-Augmented Generation (RAG) gilt als einer der vielversprechendsten Ansätze, um Sprachmodelle mit dynamischen, domänenspezifischen Informationen anzureichern. Der Erfolg dieser Systeme hängt jedoch maßgeblich davon ab, wie gut die zugrunde liegenden Inhalte strukturiert, segmentiert und mit Metadaten versehen sind. Diese Studie untersucht die entscheidende Rolle von Chunks – also logisch zusammenhängenden Texteinheiten – und analysiert, wie verschiedene Chunking-Strategien die Antwortqualität, das Kontextverständnis und die semantische Tiefe in RAG-Systemen beeinflussen.

Im Zentrum steht die Frage: Welche Formen der Textstrukturierung sind optimal, um hochwertige, skalierbare und modellübergreifende RAG-Systeme zu ermöglichen? Dabei werden zentrale Strategien wie feste Chunk-Größen, rekursives Chunking, semantische und satzbasierte Segmentierung, agentic Chunking sowie dokumentorientierte Verfahren vorgestellt und praxisnah verglichen. Literarische und normative Texte – wie Franz Kafkas „Die Verwandlung“ oder die „Allgemeine Erklärung der Menschenrechte“ – dienen als anschauliche Beispiele.

Neben den Segmentierungsstrategien wird auch der Umgang mit Metadaten, die Integration von Embedding-Software, die technische Limitierung durch Token-Fenster sowie die Rolle von Datenformaten (z. B. PDF, HTML, Markdown, XML) untersucht. Der technologische Kontext reicht dabei von klassischen Transformationsmethoden (XSLT, XML) bis zu modernen KI-Technologien (LLMs, Embeddings, Vektordatenbanken).

Ein zentrales Anliegen der Studie ist es, aus dem derzeit oft fragmentierten Feld der RAG-Implementierungen eine strukturierte, robuste und zukunftssichere Architektur herauszuarbeiten – unabhängig von spezifischen Modellen oder proprietären Technologien.

Zusammenfassung dieser Studie

Die vorliegende Studie zeigt, dass strukturierte Datenformate und intelligente Chunking-Strategien entscheidend für die Leistungsfähigkeit von RAG-Systemen sind. Unterschiedliche Segmentierungsmethoden wie rekursives, satzbasiertes, semantisches oder agentic Chunking ermöglichen eine passgenaue Aufbereitung für unterschiedliche LLMs – vorausgesetzt, sie basieren auf sauber strukturierten, medienneutralen Ausgangsdaten.

Die Analyse verschiedener Formate zeigt, dass unstrukturierte Quellen wie PDFs deutliche Nachteile aufweisen, insbesondere im Hinblick auf Metadaten, Kontextwahrung und Referenzierbarkeit. Markdown und XML hingegen bieten durch explizite Strukturierung eine solide Grundlage für automatisiertes Chunking und semantische Erschließung.

In der Fallstudie eines Wissenschaftsverlags wird gezeigt, wie ein zentraler XML-Hub kombiniert mit dynamischer Chunk-Generierung und einem Content Delivery Service (CDS) ein nachhaltiges, anpassungsfähiges RAG-Ökosystem ermöglichen kann. Besonders hervorgehoben wird die Trennung von Datenstrukturierung und Datenhaltung als Schlüssel zur technologischen Unabhängigkeit und Zukunftssicherheit.

Die Studie liefert nicht nur theoretische Grundlagen, sondern auch konkrete Umsetzungsempfehlungen, etwa zur Wahl geeigneter Chunk-Größen, zur Gestaltung von Overlapping und Redundanz, zur semantischen Anreicherung durch Metadaten sowie zur Integration von Embedding-Software und Vektordatenbanken.

Ausblick auf weitere Studien

Im Anschluss an diese Studie folgen zwei weitere Untersuchungen:

-

Automatisiertes Chunking aus allen Formaten:

Entwicklung einer vollautomatischen Infrastruktur zur Erzeugung beliebiger Chunk-Strategien, unterstützt durch das System Octopus, das auch aus PDFs medienneutrale Strukturen extrahiert. -

Zusammenarbeit mit dem CDS:

Untersuchung der Rolle eines Content Delivery Services (CDS) als semantische Vermittlungsschicht zwischen strukturierten Inhalten und RAG-Komponenten – mit RDF, SPARQL und containerbasierten Zugriffskonzepten (z. B. iiRDS).

Diese nächsten Studienabschnitte werden zeigen, wie aus strukturierten Inhalten und intelligenter Systemarchitektur ein leistungsfähiges, modell-agnostisches RAG-System entstehen kann.

1 Überblick zur RAG-Technologie

Retrieval-Augmented Generation (RAG) ist ein innovativer Ansatz innerhalb der Künstlichen Intelligenz, der klassische Textgenerierung durch die Integration externer Wissensquellen erweitert. Dabei werden große Sprachmodelle (Large Language Models, LLMs) mit einer sogenannten Retrieval-Komponente kombiniert. Ziel ist es, nicht nur auf statisches, vortrainiertes Wissen zurückzugreifen, sondern dynamisch aktuelle und domänenspezifische Informationen in die Antwortgenerierung einzubeziehen.

Der RAG-Ansatz reagiert auf ein zentrales Problem herkömmlicher LLMs: Diese sind zwar in der Lage, syntaktisch korrekte und semantisch plausible Texte zu erzeugen, stoßen jedoch an ihre Grenzen, wenn es um faktenbasierte Genauigkeit oder Spezialwissen geht, das nicht Teil des Trainingskorpus war. RAG-Systeme lösen dieses Problem, indem sie während des Antwortprozesses gezielt relevante Informationen aus einer durchsuchbaren externen Wissensbasis abrufen.

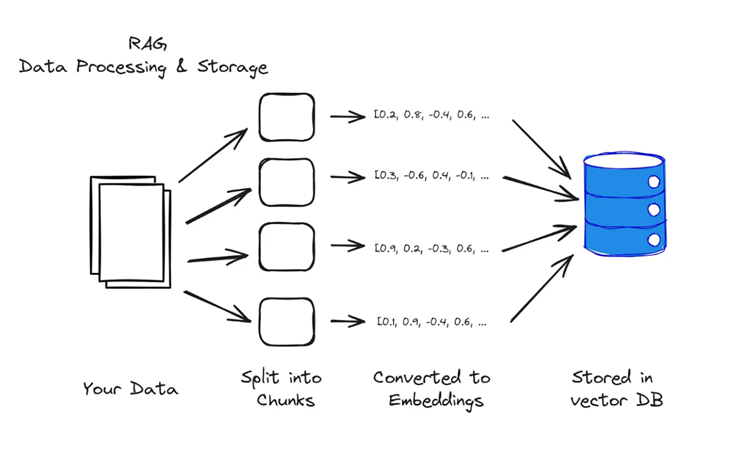

1.1 Von der Dokumentverarbeitung zur Indexierung

Die Grundlage jedes RAG-Systems bildet die effiziente und strukturierte Verarbeitung von Datenquellen. Der Prozess beginnt mit der Auswahl und Aufbereitung geeigneter Dokumente. Dabei spielen sowohl die Formatvielfalt als auch der Strukturierungsgrad der Ausgangsdaten eine zentrale Rolle. Dokumente können in unterschiedlichen Formaten vorliegen – typischerweise als PDF, HTML, Markdown oder XML. Während strukturierte Formate wie XML oder Markdown semantische Informationen wie Überschriften, Absätze, Fußnoten oder Metadaten explizit auszeichnen, sind diese Informationen in PDF-Dokumenten nur implizit vorhanden oder sogar verloren gegangen. Dies erschwert die automatische Verarbeitung erheblich.

(Quelle: https://medium.com/@BitsOfChris/what-is-rag-and-how-can-it-be-used-to-train-llms-on-your-own-data-91a0bab96842)

Nach der Extraktion der Inhalte erfolgt das sogenannte Chunking. Dabei werden die Textinhalte in kleinere Einheiten unterteilt, um sie für Sprachmodelle besser verarbeitbar zu machen. Die Größe der Chunks kann nach verschiedenen Kriterien gewählt werden – z. B. nach Wortanzahl, Zeichenanzahl oder Tokens. Letzteres ist besonders relevant, da LLMs intern mit Tokens arbeiten und eine maximale Kontextlänge aufweisen. Chunking dient nicht nur der technischen Limitierung, sondern trägt auch zur besseren Kontextualisierung der Daten bei. Überlappende Chunks werden eingesetzt, um Informationsbrüche an den Segmentgrenzen zu vermeiden.

Optional kann semantisches Tagging durchgeführt werden. Dabei werden Chunks mit Metainformationen versehen, etwa zur thematischen Einordnung, Autorenschaft oder Kapitelzugehörigkeit. Dies erleichtert die spätere Suche nach kontextrelevanten Inhalten. Anschließend werden die Chunks durch ein Embedding-Modell in mehrdimensionale Vektoren überführt, welche die semantische Bedeutung der Inhalte abbilden. Diese Vektoren werden in einer Vektordatenbank gespeichert – z. B. FAISS, ChromaDB oder Pinecone – und bilden den Index für das Retrieval-Modul des RAG-Systems.

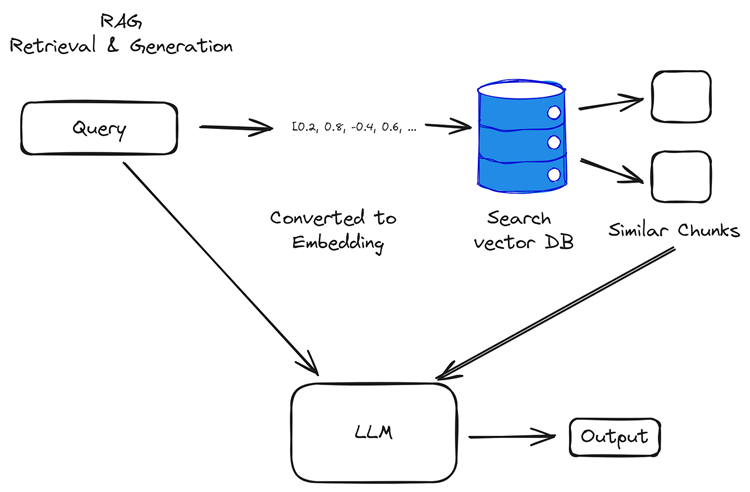

1.2 Von der Nutzeranfrage zur Antwortgenerierung

Die zweite zentrale Komponente eines RAG-Systems ist der Antwortprozess. Ausgangspunkt ist eine Nutzeranfrage, die in natürlicher Sprache formuliert wird. Diese wird im ersten Schritt in einen semantischen Vektor umgewandelt – analog zur Indexierung der Dokumenten-Chunks – mithilfe des identischen oder eines kompatiblen Embedding-Modells.

(Quelle: https://medium.com/@BitsOfChris/what-is-rag-and-how-can-it-be-used-to-train-llms-on-your-own-data-91a0bab96842)

Im nächsten Schritt erfolgt das sogenannte Retrieval. Dabei wird der Anfragevektor mit den in der Vektordatenbank gespeicherten Chunks verglichen. Ziel ist es, jene Textabschnitte zu identifizieren, deren semantische Nähe zur Anfrage am größten ist. Dies basiert typischerweise auf Metriken wie dem Kosinus-basierten Ähnlichkeitsmaß. Die relevantesten Chunks – meist die Top-N-Retrievals – werden ausgewählt und dem Sprachmodell als Kontext übergeben.

In der abschließenden Phase generiert das LLM eine Antwort unter Berücksichtigung der abgerufenen Chunks. Dieser Vorgang kann als kontextgestützte Generierung bezeichnet werden. Das Modell nutzt die übergebenen Dokumentauszüge als Wissensbasis, formuliert aber die Antwort autonom in natürlicher Sprache. Dadurch entsteht eine Synergie aus datengetriebener Präzision und sprachlicher Flexibilität.

Der Erfolg eines RAG-Systems hängt maßgeblich von der Qualität der Chunks, der Leistungsfähigkeit der Embeddings sowie der Effektivität der Retrieval-Komponente ab. Eine präzise abgestimmte Pipeline zwischen Dokumentaufbereitung, Vektorisierung und Antwortgenerierung ist entscheidend für den praktischen Nutzen.

1.3 Formatabhängigkeit und Modellpräferenzen

Ein oft unterschätzter Aspekt bei der Implementierung von RAG-Systemen ist die Formatabhängigkeit in Bezug auf das eingesetzte Large Language Model (LLM). Nicht jedes Modell verarbeitet alle Datenformate gleichermaßen effektiv. Es hat sich gezeigt, dass strukturierte Formate wie Markdown häufig zu besseren Antwortqualitäten führen – insbesondere bei Modellen, die explizite semantische Strukturen aus dem Text extrahieren und kontextuell weiterverarbeiten können. Markdown bietet durch klar definierte Elemente wie Überschriften, Listen, Tabellen und Fußnoten eine zusätzliche semantische Schicht, die von modernen LLMs gut interpretiert werden kann.

Demgegenüber steht die Verwendung von Plain Text, der keinerlei semantische Markierungen aufweist. Während dieser für manche Anwendungsfälle ausreichend sein kann, fehlt ihm häufig die strukturelle Tiefe, um komplexe Kontexte exakt abzubilden. Daher ist es bei der Gestaltung eines RAG-Systems ratsam, je nach LLM-Architektur und Zielanwendung eine geeignete Datenaufbereitung zu wählen. Eine format-adaptive Strategie kann die Antwortqualität signifikant verbessern und sollte als Best Practice etabliert werden.

2 Was sind Chunks – und warum werden Texte in Chunks aufgeteilt?

2.1 Was sind Chunks?

Chunks sind kleine, logisch zusammenhängende Textsegmente, in die ein großer Text zerlegt wird. Diese Zerlegung ist insbesondere in der Arbeit mit großen Sprachmodellen (Large Language Models, LLMs) wie GPT oder Claude wichtig. Da diese Modelle nur eine begrenzte Menge an Text gleichzeitig verarbeiten können (z. B. 4.000 bis 32.000 Tokens), müssen längere Inhalte in verdaubare Einheiten unterteilt werden.

Ein Chunk kann beispielsweise sein:

-

300 Wörter

-

500 Zeichen

-

200 Tokens (wie von Sprachmodellen genutzt)

Je nach Anwendungsfall und Modell kommen unterschiedliche Strategien zum Einsatz. Manche Systeme chunken nach Absätzen, andere entlang semantischer Einheiten oder nach einer fixen Längenvorgabe.

|

Definition 2.1

|

|||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

Vergleich Tokens vs. Chunks:

|

2.2 Warum wird gechunkt?

Es gibt technische, strukturelle und semantische Gründe, Texte in Chunks zu unterteilen:

-

Modellbegrenzungen

LLMs können nur eine bestimmte Kontextlänge verarbeiten. Ohne Chunking wären längere Texte gar nicht nutzbar. -

Leichtere Analyse

Kleinere Einheiten sind einfacher zu durchsuchen, zu analysieren und zu bewerten – etwa im Information Retrieval oder bei der Embedding-Erstellung. -

Erhalt von Kontext

Mit intelligentem Chunking (z. B. überlappende Segmente) lassen sich Zusammenhänge über Chunk-Grenzen hinweg bewahren. -

Effizienteres Prompting

Chunks können selektiv in Prompts eingebunden werden, sodass das Modell nur relevante Teile erhält – das spart Kosten und erhöht die Präzision.

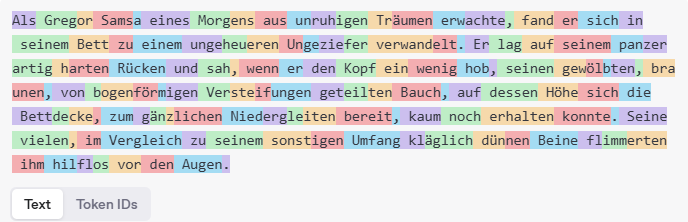

2.3 Vereinfachtes Beispiel: Chunking aus Kafkas „Die Verwandlung“

Originaltext (Auszug Anfangssatz):

„Als Gregor Samsa eines Morgens aus unruhigen Träumen erwachte, fand er sich in seinem Bett zu einem ungeheueren Ungeziefer verwandelt.“

Wortbasiertes Chunking (10-Wörter-Chunks):

-

Chunk 1: „Als Gregor Samsa eines Morgens aus unruhigen Träumen erwachte fand“

-

Chunk 2: „er sich in seinem Bett zu einem ungeheueren Ungeziefer verwandelt“

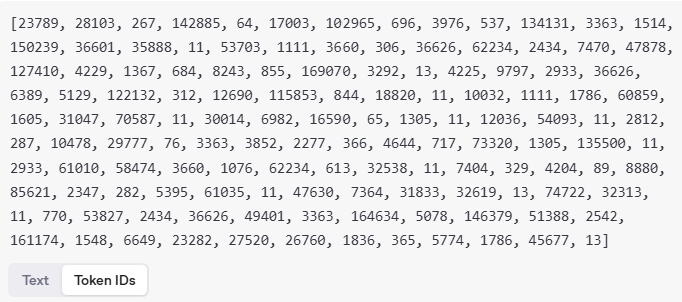

Token-basiertes Chunking (Beispiel mit GPT-4 Tokenizer, vereinfacht):

-

Chunk 1: ["Als", "Gregor", "Samsa", "eines", "Morgens", "aus", "unruhigen", "Träumen", "erwachte", "fand"]

-

Chunk 2: ["er", "sich", "in", "seinem", "Bett", "zu", "einem", "ungeheueren", "Ungeziefer", "verwandelt", "."]

Chunking mit semantischer Annotation in JSON codiert

{

"content": "Als Gregor Samsa eines Morgens ...",

"metadata": {

"person": "Gregor Samsa",

"motiv": "Verwandlung",

"werk": "Die Verwandlung"

}

}|

Hinweis 2.1

|

|---|

|

Durch Chunking bleibt der Text für Maschinen verarbeitbar – und für Menschen interpretierbar. Im Fall literarischer Werke wie Die Verwandlung ist dabei besonders wichtig, dass Sinnzusammenhänge (z. B. Figuren, Motive, symbolische Elemente) beim Zerlegen nicht verloren gehen. |

3 Chunk-Größen – Empfehlungen für verschiedene LLMs

3.1 Chunk-Größe als strategische Stellschraube

Die Wahl der richtigen Chunk-Größe ist ein zentrales Element beim Aufbau eines performanten RAG-Systems. Sie beeinflusst direkt:

-

wie viel Kontext ein Modell verarbeiten kann,

-

wie präzise und vollständig Antworten ausfallen,

-

wie effizient Speicher- und Rechenressourcen genutzt werden.

Eine zu große Chunk-Größe kann dazu führen, dass relevante Inhalte vom Modell abgeschnitten werden oder unnötiger Kontext eingebettet wird. Eine zu kleine Chunk-Größe wiederum erhöht die Anzahl der Chunks, erschwert das Retrieval und kann den Zusammenhang zerreißen.

3.2 Empfohlene Chunk-Größen für gängige LLMs

|

Modell |

Maximale Kontextlänge (Tokens) |

Empfohlene Chunk-Größe |

Kommentar |

|

GPT-3.5 Turbo |

4.096 Tokens |

200–600 Tokens |

20–30 % Puffer lassen |

|

GPT-4 (32k) |

32.768 Tokens |

1.000–2.000 Tokens |

Eher große Chunks möglich |

|

Claude 2 |

100.000 Tokens (theoretisch) |

1.500–4.000 Tokens |

Ideal für große Kontexte |

|

Mistral |

8.192 Tokens |

300–1.000 Tokens |

Puffer wegen Prompt-Anteilen |

|

LLaMA 2 |

4.096–8.192 Tokens |

300–800 Tokens |

Tokens stark modellabhängig |

Diese Werte sind keine starren Regeln, sondern Richtwerte. Entscheidend ist der Einsatzzweck: Für klassische Frage-Antwort-Szenarien genügen oft 300–500 Tokens. Für semantische Suche mit Kontextaggregation können größere Chunks sinnvoll sein.

Empfehlungen für die Praxis

-

Puffer einplanen

Mindestens 20–30 % der Kontextlänge sollten für Prompts, Anweisungen und Modellantworten reserviert bleiben. -

Chunk-Größe dynamisch anpassen

Anstatt fixer Token-Anzahl kann Chunking entlang semantischer Grenzen erfolgen (Absätze, Zwischenüberschriften), ergänzt durch Token-Limits. -

Größe mit Overlap kombinieren

Bei 600 Tokens Chunk-Größe kann z. B. ein Overlap von 100–150 Tokens sinnvoll sein, um Kontextübergänge zu glätten. -

Analyse- und Antworttyp berücksichtigen

-

Für faktische Antworten: kleinere Chunks, prägnant.

-

Für kreative/analytische Aufgaben: größere Chunks, mehr Kontext.

-

-

Testen und iterieren

Ideale Chunk-Größen variieren je nach Textgattung (Belletristik ≠ Forschung ≠ News). A/B-Tests oder Recall/Precision-Messungen helfen bei der Optimierung.

3.3 Warum man nicht die maximale Kontextlänge als Chunk-Größe nutzen sollte

3.3.1 Was ist die Kontextlänge eines LLMs überhaupt?

Die Kontextlänge eines Large Language Models (LLM) beschreibt die maximale Anzahl an Tokens, die das Modell gleichzeitig verarbeiten kann. Diese Tokens beinhalten alles, was dem Modell übergeben wird – also nicht nur den Textinhalt (z. B. ein Chunk), sondern auch:

-

den Prompt (z. B. die Frage oder Aufgabe),

-

Systemnachrichten (z. B. Rolleninformationen wie: „Du bist ein hilfreicher Assistent“),

-

gegebenenfalls Beispielantworten oder andere Steuerinformationen,

-

und die Modellantwort selbst (falls sie im selben Kontext zurückfließt, z. B. bei Chat-Modellen).

Beispiel: GPT-3.5 mit 4.096 Tokens

Angenommen, ein Modell wie GPT-3.5 hat eine maximale Kontextlänge von 4.096 Tokens. Wenn Sie nun einen Textchunk mit exakt 4.096 Tokens übergeben, passiert Folgendes:

-

Es bleibt kein Platz mehr für Ihren Prompt.

-

Das Modell „sieht“ möglicherweise nur einen Teil des Chunks – oder bricht die Verarbeitung ab.

-

Bei Chat-Modellen kann auch die Antwort abgeschnitten oder gar nicht erzeugt werden, weil kein Raum mehr dafür da ist.

Ergebnis: Antworten werden unvollständig, das Modell reagiert fehlerhaft oder gibt gar nichts zurück.

3.3.2 Warum ein Puffer notwendig ist

Um diese Probleme zu vermeiden, empfiehlt sich ein Puffer von 20–30 % der Gesamtkontextlänge. Dieser wird benötigt für:

-

Prompt: Fragen oder Anweisungen („Fasse den folgenden Text zusammen“, „Antworte in einfacher Sprache“, etc.).

-

Systemkonfiguration: Rollenzuweisung, Spracheinstellungen, Antwortformat.

-

Nachfolgende Interaktionen: Im Chatverlauf können frühere Einträge weiter mitgeschickt werden.

-

Antwortspielraum: Das Modell braucht Raum, um vollständige Antworten zu erzeugen.

Beispiel:

Bei GPT-3.5 (4.096 Tokens) sollte dein Chunk nicht größer als ca. 2.800–3.000 Tokens sein, um einen verlässlichen Puffer für alles andere zu lassen.

3.3.3 Risiken bei zu großen Chunks

-

Abschneiden: Das Modell bricht mitten im Satz ab – wichtige Informationen gehen verloren.

-

Verzerrte Antworten: Ohne vollständigen Prompt oder ohne Antwortpuffer antwortet das Modell ungenau oder „halluziniert“.

-

Systemfehler: Einige APIs lehnen Eingaben über der Kontextgrenze komplett ab.

4 Chunking-Strategien

Unter Chunking-Strategien versteht man systematische Methoden zur Aufteilung eines größeren Textes in kleinere, handhabbare Einheiten – sogenannte Chunks. Diese Strategien spielen eine zentrale Rolle in RAG-Systemen (Retrieval-Augmented Generation), da große Sprachmodelle (LLMs) nur eine begrenzte Menge an Text gleichzeitig verarbeiten können. Je nach Zielsetzung und Textart kommen unterschiedliche Strategien zum Einsatz, um Kontext zu erhalten, relevante Inhalte leichter auffindbar zu machen und die Effizienz bei der Antwortgenerierung zu steigern. Im Folgenden werden acht relevante Chunking-Strategien anhand literarischer und normativer Texte illustriert – insbesondere anhand von Franz Kafkas „Die Verwandlung“ sowie der „Allgemeinen Erklärung der Menschenrechte“.

4.1 Chunking mit fester Größe

Chunking mit fester Größe ist eine der grundlegendsten und technisch einfachsten Methoden zur Segmentierung von Texten für die Weiterverarbeitung in Retrieval-Augmented-Generation-(RAG-)Systemen. Dabei wird der Text unabhängig von seiner inhaltlichen Struktur oder semantischen Kohärenz in gleich große Abschnitte – sogenannte Chunks – aufgeteilt. Die Größe dieser Einheiten kann je nach Anwendungsfall auf Grundlage von Wörtern, Zeichen oder Tokens bestimmt werden. Typische Einstellungen umfassen zum Beispiel 100 Wörter, 500 Zeichen oder 300 Tokens pro Chunk.

Das Ziel dieser Strategie liegt vor allem in ihrer Standardisierbarkeit: Durch die gleichmäßige Zerlegung großer Textmengen lassen sich Daten sehr effizient vorbereiten und verarbeiten, insbesondere in automatisierten Pipelines, bei denen semantische Tiefe zunächst eine untergeordnete Rolle spielt. In Szenarien mit strikten Längenvorgaben – etwa bei API-Schnittstellen oder der Speicheroptimierung in Vektordatenbanken – erweist sich diese Methode als besonders nützlich.

Allerdings geht diese Einfachheit zulasten des Inhaltszusammenhangs. Da die Chunk-Grenzen nicht auf natürliche Sprachelemente wie Sätze oder Absätze Rücksicht nehmen, können bedeutungstragende Einheiten auseinandergerissen werden. Dies kann sich negativ auf das Antwortverhalten von Sprachmodellen auswirken, da wichtige Informationen möglicherweise auf mehrere Chunks verteilt sind und dadurch Kontext verloren geht.

Ein Beispiel aus Franz Kafkas „Die Verwandlung“ verdeutlicht dies: Wird der berühmte Eingangssatz des Werks in 10-Wort Chunks aufgeteilt, ergibt sich folgendes Bild:

{

"text": "Als Gregor Samsa eines Morgens aus unruhigen Träumen erwachte, fand"

},

{

"text": "er sich in seinem Bett zu einem ungeheueren Ungeziefer verwandelt."

},

{

"text": "Er lag auf seinem panzerartig harten Rücken und sah, wenn"

},Obwohl jeder Chunk formal korrekt segmentiert ist, wird die inhaltliche Einheit des Satzes gebrochen, was den semantischen Zusammenhang erschwert.

Hier mit Tokens und den Text zur besseren Einordnung:

{

"text": "Als Gregor Samsa eines Morgens aus",

"token_ids": [

77968,

16431,

269,

328,

4214,

64,

37208,

79160,

729,

9608

]

},

{

"text": " unruhigen Träumen erwachte,",

"token_ids": [

653,

2739,

71,Trotz dieser Schwächen bleibt Chunking mit fester Größe eine weit verbreitete Methode, insbesondere in frühen Phasen der Datenvorverarbeitung oder in Kombination mit überlappenden Chunks und nachgelagerter Kontextrekonstruktion. Ihre Stärke liegt vor allem in der Einfachheit, Berechenbarkeit und Effizienz bei der Handhabung großer Textkorpora – insbesondere bei vollautomatisch erzeugten Chunks, etwa aus PDF-Dateien, in denen feste Längen verwendet werden, da sie sich besonders leicht berechnen lassen. Die potenziellen Nachteile wie semantische Brüche, Zerschneidung grammatischer Einheiten oder Kontextverluste werden dabei in vielen Fällen bewusst in Kauf genommen, um eine möglichst schnelle und skalierbare Verarbeitung zu ermöglichen.

Ein besonders problematischer Aspekt ist der Umgang mit tabellarischen Daten: Tabellen verlieren durch feste Blockierungen häufig ihre logische Struktur – etwa Spaltenüberschriften, Zellbezüge oder Zeilenzusammenhänge – und werden dadurch semantisch „tot“. Sie können vom Modell weder als funktionale Einheit erfasst noch korrekt rekonstruiert werden. Dies betrifft insbesondere komplexe Tabellenlayouts aus wissenschaftlichen Publikationen, Geschäftsberichten oder Normdokumenten, die beim Parsing aus PDF-Quellen ohnehin anfällig für Fragmentierung sind. In der Folge leidet nicht nur die semantische Auswertbarkeit, sondern auch die Antwortqualität bei KI-basierten Retrieval-Systemen erheblich.

Darüber hinaus betrifft das Chunking mit fester Größe auch semantisch bedeutungsvolle Metainformationen, wie etwa Fußnoten, Literaturverweise, Marginalien oder Quellenangaben. Diese erscheinen im Fließtext häufig außerhalb ihres semantischen Kontexts und verlieren dadurch ihre Referenzfunktion. Beispielsweise kann eine Fußnote am Ende eines Absatzes in einen separaten Chunk fallen, ohne dass das zugehörige Zitat erhalten bleibt – was sowohl für Leser:innen als auch für Sprachmodelle zu einem vollständigen Bedeutungsverlust führt. Besonders in wissenschaftlichen oder juristischen Texten ist dies ein kritisches Problem, da Belegstellen und formale Bezüge eine zentrale Rolle für das Textverständnis spielen.

Mehr Informationen zum Thema, welche Strukturen betroffen sind, finden sich in Teil 1 der RAG-Studienreihe „Strukturierte vs. unstrukturierte Daten im RAG-Training: ein Vergleich“.

4.2 Rekursives Chunking

Das rekursive Chunking stellt eine erweiterte und deutlich flexiblere Form der Textsegmentierung dar. Im Gegensatz zu linearen Methoden mit fester Chunk-Größe basiert diese Strategie auf einer hierarchischen Analyse der Textstruktur. Dabei erfolgt die Zerlegung des Textes nicht unmittelbar in gleich große Einheiten, sondern in mehreren Stufen – stets entlang der nächstkleineren inhaltlichen oder formalen Einheit, sobald ein definierter Grenzwert (z. B. eine maximale Token-Anzahl) überschritten wird.

4.2.1 Prinzip und Zielsetzung

Im Zentrum dieser Methode steht die Idee, semantische Kohärenz so weit wie möglich zu erhalten, während gleichzeitig technische Limitierungen – insbesondere Token-Limits bei Sprachmodellen – eingehalten werden. Die Segmentierung beginnt in der Regel auf höherer Gliederungsebene, etwa bei Absätzen oder Sektionen. Sollte eine dieser Einheiten den festgelegten Grenzwert überschreiten, wird sie rekursiv weiter unterteilt, beispielsweise in Sätze. Ist selbst ein Satz zu lang (was bei verschachtelten oder komplexen Sätzen vorkommen kann), kann ein weiterer Schritt folgen, bei dem schließlich auf Token-Ebene geschnitten wird.

Dieses Verfahren erlaubt eine sehr adaptive Verarbeitung, die sich der Textstruktur dynamisch anpasst. Anders als bei Chunking mit fester Größe, werden hier große semantische Einheiten nicht mechanisch zerteilt, sondern möglichst sinnvoll gegliedert.

4.2.2 Anwendung und Beispiel

Ein klassisches Beispiel für rekursives Chunking lässt sich an Franz Kafkas Erzählung „Die Verwandlung“ zeigen. Der berühmte Eingangstext besteht aus einem einzigen, sehr langen Satz:

„Als Gregor Samsa eines Morgens aus unruhigen Träumen erwachte, fand er sich in seinem Bett zu einem ungeheuren Ungeziefer verwandelt.“

Ein fester Chunking-Ansatz könnte diesen Satz unsauber unterbrechen. Beim rekursiven Vorgehen hingegen wird dieser Satz als kleinste sinnvolle Einheit erkannt und nicht weiter unterteilt, da er im Ganzen unter die zulässige Token-Anzahl fällt. Bei einem nachfolgenden Absatz, der mehrere Sätze oder gar mehrere hundert Tokens umfasst, würde zunächst der Absatz als Chunk evaluiert. Falls zu lang, erfolgt die Aufteilung in Sätze. Nur wenn einzelne Sätze die Grenze überschreiten, wird auf Token-Ebene segmentiert.

4.3 Dokumentbasiertes Chunking

Das dokumentbasierte Chunking ist eine Struktur-orientierte Methode zur Segmentierung von Texten, bei der sich die Zerlegung konsequent an der natürlichen Gliederung des Dokuments orientiert. Im Gegensatz zu rein quantitativen Ansätzen, bei denen Chunks nach Wort-, Zeichen- oder Token-Anzahl geschnitten werden, folgt diese Strategie der inhärenten Aufbauweise des Textes – also an formalen Einheiten wie Kapiteln, Absätzen, Unterüberschriften oder Sektionen. Ziel ist es, semantisch zusammengehörige Abschnitte vollständig zu erhalten und so den inhaltlichen Zusammenhang und die logische Kohärenz im Chunk zu wahren.

4.3.1 Zielsetzung und Anwendungsbereich

Dokumentbasiertes Chunking ist besonders geeignet für formalisierte, gegliederte Texte, wie sie in wissenschaftlichen Artikeln, Gesetzestexten, Berichten, Lehrbüchern oder digitalen Publikationen vorkommen. Hier folgt der Inhalt in der Regel einer klaren, typografisch oder strukturell kodierten Gliederung, etwa in Kapitelüberschriften, nummerierte Absätzen, Zwischenüberschriften oder Marginalien. Diese Struktur kann über Markup-Sprachen wie XML, Markdown, LaTeX oder durch maschinelles Layout-Parsing aus PDF-Dateien erschlossen werden.

Durch die Beibehaltung solcher Einheiten wird sichergestellt, dass jedes Chunk einen sinnvollen inhaltlichen Abschnitt abbildet, der vollständig für das semantische Retrieval oder die LLM-Verarbeitung genutzt werden kann. Zudem erlaubt diese Methode eine zielgerichtete Navigation und Kontextsteuerung, etwa im Rahmen von Suchsystemen oder dialogorientierten Anwendungen (z. B. „Springe zu Abschnitt 3.2“).

4.3.2 Methodik

Technisch erfolgt das dokumentbasierte Chunking über einen strukturbewussten Parser, der das Dokument analysiert und entlang vordefinierter Strukturelemente segmentiert. Je nach Quellformat kann dies auf unterschiedlichen Ebenen geschehen:

-

In XML-Dateien etwa nach den Elementen <section>, <para>, <div> oder <article>.

-

In Markdown nach Überschriftsebenen (#, ##, ###) und Absatzumbrüchen.

Jeder identifizierte Abschnitt (z. B. ein Absatz oder ein Kapitelblock) wird dabei als ein vollständiger Chunk übernommen – ohne künstliche Unterbrechung. Nur wenn dieser Chunk die maximal zulässige Größe überschreitet (z. B. Token-Limit eines LLMs), kann ergänzend rekursiv weiter unterteilt werden (siehe Kapitel zum rekursiven Chunking 4.2).

4.3.3 Beispiel: Dokumentbasiertes Chunking der UN-Menschenrechtscharta (in Markdown, als JSON)

{

"chunk_id": "1",

"struktur": "Präambel",

"content": "Da die Anerkennung der angeborenen Würde und der gleichen und unveräußerlichen Rechte aller Mitglieder

der Gemeinschaft der Menschen ...",

"metadata": {

"typ": "prambel",

"abschnitt": "Einleitung"

}

},

{

"chunk_id": "2",

"struktur": "Artikel",

"artikel_nummer": 1,

"titel": "Artikel 1",

"content": "Alle Menschen sind frei und gleich an Würde und Rechten geboren. Sie sind mit Vernunft und Gewissen

begabt und sollen einander im Geist der Brüderlichkeit begegnen.",

"metadata": {

"typ": "artikel",

"quelle": "UN-Charta 1948",

"rechtstyp": "Menschenrecht"

}

},

{

"chunk_id": "3",

"struktur": "Artikel",

"artikel_nummer": 2,

"titel": "Artikel 2",

"content": "Jeder hat Anspruch auf alle in dieser Erklärung verkündeten Rechte und Freiheiten ...",

"metadata": {

"typ": "artikel",

"quelle": "UN-Charta 1948",

"rechtstyp": "Antidiskriminierung"

}

}

]Besonderheiten:

-

Chunk-Grenzen = Dokumentstruktur (Markdown-Level)

→ Jede H1/H2-Überschrift markiert einen logischen Abschnitt -

Metadata enthält semantisch nützliche Angaben (z. B. artikel_nummer, typ, quelle)

-

Keine künstliche Längenbegrenzung, da z. B. Artikel 1 < Token-Limit bleibt

4.3.4 Vorteile und Herausforderungen

Ein großer Vorteil des dokumentbasierten Chunkings ist die semantische Stabilität: Der Text wird in inhaltlich kohärente Einheiten zerlegt, die sich für gezieltes Nachschlagen, Annotation, semantisches Retrieval und LLM-basierte Verarbeitung besonders gut eignen. Auch Zusatzinformationen wie Fußnoten, Bildunterschriften oder Quellenverweise lassen sich bei strukturierten Dokumenten klar zuordnen.

Allerdings ist diese Methode abhängig von der Verfügbarkeit einer sauberen Dokumentstruktur.

4.4 Semantisches Chunking

Das semantische Chunking ist eine fortgeschrittene Methode der Textsegmentierung, bei der nicht die äußere Struktur, sondern der inhaltliche Bedeutungszusammenhang die Grundlage für die Chunk-Bildung darstellt. Die Zerlegung erfolgt entlang von thematischen, argumentativen oder narrativen Einheiten wie z. B. Themen, Rollen (Akteure), Absichten, Rechtsbezüge oder Diskursschwerpunkte. Ziel dieser Strategie ist es, kohärente inhaltliche Abschnitte zu extrahieren, die in sich semantisch geschlossen sind – unabhängig von formalen Layout- oder Formatierungsmerkmalen.

4.4.1 Ziel und Anwendungsfelder

Semantisches Chunking eignet sich vor allem für Texte mit komplexem Inhalt oder hohem Interpretationspotenzial – wie etwa philosophische Abhandlungen, Gesetzestexte, politische Erklärungen oder literarische Werke. Es wird in der Regel dort eingesetzt, wo bedeutungsgesteuertes Retrieval oder kontextgenaue Antwortgenerierung durch Sprachmodelle gefragt ist.

4.4.2 Methodik

Die Umsetzung erfolgt mithilfe semantischer Analyseverfahren. Dabei kommen je nach Textart Methoden wie Named Entity Recognition, Topic Classification, Intent Detection oder Large Language Models (LLMs) zum Einsatz. Im Unterschied zu strukturbasierten Verfahren orientiert sich die Chunk-Bildung hier an der inhaltlichen Funktion einer Passage: Was wird gesagt? Wer handelt? Welches Recht, welche Forderung oder welche Norm stehen im Fokus?

Bei der praktischen Umsetzung kann zusätzlich auf bereits vorhandene semantische Informationen zurückgegriffen werden, etwa aus XML-basierten Textformaten. Diese strukturellen Hinweise lassen sich mit den oben genannten Verfahren kombinieren, um die semantische Tiefe automatisch zu erweitern.

Ein Beispiel für eine solche Kombination ist die vollautomatische Generierung von Stichwörtern oder Metadaten mithilfe eines hybriden Workflows aus XSLT-Transformation, Python-Verarbeitung und LLM-gestützter Klassifikation. So können Texte nicht nur gechunkt, sondern gleichzeitig strukturreich erschlossen und inhaltlich klassifiziert werden – etwa nach Thema, Akteurs-Rolle oder Argumentationsfunktion. Dies eröffnet insbesondere im Bereich der Normtextanalyse, der juristischen Kommentierung oder der literaturwissenschaftlichen Interpretation neue Möglichkeiten der maschinellen Erschließung.

4.4.3 Beispiel: Semantisches Chunking der UN-Menschenrechtscharta

Die Allgemeine Erklärung der Menschenrechte (AEMR) gliedert sich formal in Artikel. Doch innerhalb dieser Artikel lassen sich inhaltlich unterschiedliche Aussagen oder semantische Agentenrollen erkennen – etwa, ob vom „Menschen“, vom „Staat“ oder vom „Gesetz“ die Rede ist.

Artikel 1 (Originaltext):

„Alle Menschen sind frei und gleich an Würde und Rechten geboren. Sie sind mit Vernunft und Gewissen begabt und sollen einander im Geist der Brüderlichkeit begegnen.“

Semantisch gechunkte Darstellung (zwei semantische Einheiten):

[

{

"chunk_id": 1,

"article": "1",

"content": "Alle Menschen sind frei und gleich an Würde und Rechten geboren.",

"metadata": {

"rolle": "Mensch",

"thema": "Menschenwürde",

"rechtsstatus": "angeboren"

}

},

{

"chunk_id": 2,

"article": "1",

"content": "Sie sind mit Vernunft und Gewissen begabt und sollen einander im Geist der Brüderlichkeit begegnen.",

"metadata": {

"rolle": "Mensch",

"thema": "Verantwortung",

"norm": "Brüderlichkeit"

}

}

]4.4.4 Vorteile und Herausforderungen

Semantisches Chunking ermöglicht eine bedeutungserhaltende Verarbeitung komplexer Inhalte, was gerade bei rechtlichen, politischen oder moralphilosophischen Texten entscheidend ist. Es erlaubt Systemen wie RAG-Modellen, gezielt nach thematisch relevanten Einheiten zu suchen – etwa alle Chunks, in denen „Würde“ oder „Diskriminierung“ thematisiert wird.

Allerdings ist die Methode nicht einfach zu automatisieren: Sie setzt eine tiefgehende inhaltliche Analyse voraus und erfordert entweder manuelle Annotation oder den Einsatz leistungsfähiger LLMs. Zudem können Überschneidungen auftreten, etwa wenn ein Abschnitt mehreren Themen gleichzeitig zuzuordnen ist.

4.4.5 Agentic Chunking

Agentic Chunking ist eine semantikbasierte Strategie zur Textsegmentierung, bei der die Gliederung entlang der im Text auftretenden handelnden oder adressierten Akteure (Agenten) erfolgt. Im Fokus stehen dabei Rollen wie „Individuum“, „Staat“, „Organisation“ oder „Lehrer“ und „Schüler“, denen innerhalb eines normativen oder deklarativen Dokuments bestimmte Rechte, Pflichten oder Handlungsräume zugewiesen werden. Ziel ist es, Inhalte nicht entlang formaler Strukturmerkmale, sondern entlang der inhaltlichen Verantwortungsverteilung zu gliedern.

Diese Methode eignet sich besonders für Texte, in denen unterschiedliche Rollen klar voneinander abgrenzbar sind – etwa in Verfassungen, internationalen Konventionen, politischen Grundsatztexten oder im Bildungsbereich. Durch die agentenbasierte Segmentierung bleibt die inhaltliche Kohärenz innerhalb eines Rollenbezuges erhalten, während Vermischungen oder Kontextverluste vermieden werden. So kann etwa die Verantwortung des Staates, die Entscheidungsfreiheit der Eltern und das Recht des Individuums jeweils als separate, in sich geschlossene Einheit verarbeitet werden.

Agentic Chunking basiert häufig auf LLM-gestützter Analyse, bei der kleine Vorsegmente (Mini-Chunks) zunächst unabhängig voneinander interpretiert und anschließend nach Agentenzugehörigkeit gruppiert werden. Diese semantische Gruppierung wird durch kontextuelle Überlappung stabilisiert und kann durch rekursive oder Token-basierte Verfahren ergänzt werden, falls die Textlänge es erfordert.

Vergleich: traditionelles vs. agentic Chunking

Die folgende Tabelle vergleicht verschiedene Aspekte in Bezug auf traditionelles und auf agentic Chunking:

|

Aspekt |

Traditionelles Chunking |

Agentic Chunking |

|

Segmentierungsprinzip |

Satz, Absatz, Token |

Rolle / Akteur |

|

Kontexterhalt |

begrenzt |

hoch (semantisch geschlossen) |

|

Perspektivtrennung |

nicht vorgesehen |

explizit |

|

Technische Umsetzung |

regelbasiert |

LLM-gestützt, dynamisch |

|

Eignung für Normtexte |

eingeschränkt |

sehr hoch |

|

Automatisierungsgrad |

hoch, aber oberflächlich |

komplex, aber präzise |

Agentic Chunking trägt entscheidend dazu bei, inhaltliche Rollenverteilungen sauber zu erfassen, und ist damit besonders relevant für Aufgaben, bei denen Verantwortlichkeiten, Rechte und Rollenverständnisse differenziert analysiert werden müssen – etwa in juristischen Anwendungen, im Bildungsbereich oder bei der normativen Wissenserschließung.

4.5 Token-basiertes Chunking

Das Token-basierte Chunking ist eine methodisch präzise Strategie zur Aufteilung von Texten, bei der sich die Segmentierung an der internen Verarbeitungseinheit von Sprachmodellen orientiert: den sogenannten Tokens. Tokens sind nicht identisch mit Wörtern – je nach Sprache und Wortstruktur kann ein einziges Wort aus mehreren Tokens bestehen, während manche kurze Wörter nur ein Token umfassen. So wird beispielsweise „Gregor“ als ein Token, „Samsa“ als ein weiteres Token gezählt.

Diese Form des Chunkings wird vor allem in Zusammenhang mit Large Language Models (LLMs) wie GPT-4, Claude oder LLaMA verwendet, da diese Modelle konkrete Token-Limits pro Eingabe besitzen – typischerweise zwischen 2048 und 8192 Tokens, je nach Modell und Version. Um sicherzustellen, dass ein Input den Kontextbereich eines LLMs nicht überschreitet, wird der Text im Vorfeld in Token-genaue Einheiten zerteilt.

4.5.1 Ziel und Anwendung

Ziel des Token-basierten Chunkings ist eine optimierte Vorbereitung von Texten für LLM-Anfragen, etwa im Rahmen von Retrieval-Augmented Generation, Prompt Engineering oder fein abgestimmten Frage-Antwort-Systemen. Diese Methode bietet eine sehr präzise Steuerung, da der Input exakt auf das technisch erlaubte Maß zugeschnitten werden kann – ideal für Anwendungen mit festen Kontextgrenzen (z. B. 4096 Token bei GPT-3.5).

Ein Beispiel aus Kafkas Die Verwandlung verdeutlicht die Feinheit der Tokenisierung:

4.5.2 Kombination mit anderen Strategien

Token-basiertes Chunking ist nicht zwingend eigenständig, sondern kann oder muss mit anderen Strategien kombiniert werden. Insbesondere beim semantischen Chunking, das sich primär an inhaltlichen Kriterien orientiert, erweist sich eine zusätzliche Token-basierte Begrenzung häufig als unumgänglich. Auch wenn ein Abschnitt inhaltlich als abgeschlossen betrachtet werden kann – etwa thematisch kohärent oder argumentativ vollständig ist –, kann seine Länge dennoch die technischen Limitierungen eines Sprachmodells überschreiten. In solchen Fällen ist eine weitere Aufteilung nicht inhaltlich motiviert, sondern wird ausschließlich durch systemseitige Beschränkungen erzwungen. Dies kann zu Brüchen innerhalb zusammenhängender Argumentationen oder thematischer Übergänge führen, lässt sich jedoch in vielen Systemen nicht vermeiden, wenn Modellkompatibilität gewährleistet werden soll.

Ein typisches Beispiel ist ein Chunk, der aus einem semantisch konsistenten Abschnitt besteht – etwa einem Kapitel über „Menschenwürde“ in einem Grundlagentext –, das jedoch mehr als 400 Tokens umfasst. In solchen Fällen wird der semantisch definierte Chunk zusätzlich durch ein Token-basiertes Limit aufgeteilt:

{

"strategy": "semantisch + token-basiert",

"max_tokens": 400,

"chunk_id": 12,

"content": "...",

"metadata": {

"thema": "Menschenwürde",

"quelle": "Artikel 1",

"rolle": "Mensch"

}

}Damit fungiert das Token-basierte Chunking als eine präzise Begrenzungsschicht – insbesondere bei automatisch generierten, thematisch komplexen Chunks, die aus längeren Abschnitten stammen.

4.5.3 Implikationen für die Praxis

Token-basiertes Chunking ist eine modellnahe, effiziente Strategie, um Texte verlässlich innerhalb technischer Vorgaben zu halten. In Kombination mit semantischen, strukturellen oder rekursiven Verfahren lässt sich theoretisch eine ausgewogene Balance zwischen inhaltlicher Kohärenz und technischer Effizienz anstreben – ein Ziel, das für robuste RAG-Systeme von zentraler Bedeutung ist.

In der Praxis gestaltet sich diese Kombination jedoch technisch nicht trivial, da die Tokenisierung modellabhängig ist: Verschiedene Sprachmodelle verwenden unterschiedliche Tokenizer, wodurch sich die tatsächliche Token-Anzahl eines Textes erst nachträglich bestimmen lässt. Das bedeutet, dass semantisch oder strukturell definierte Chunks zunächst erzeugt und anschließend rückwirkend auf ihre Token-Länge geprüft und gegebenenfalls nachjustiert werden müssen. Dabei besteht stets die Herausforderung, die ursprüngliche Kohärenz des Inhalts möglichst wenig zu beeinträchtigen, selbst wenn die Chunk-Grenzen rein aus technischen Gründen angepasst werden müssen.

4.6 Satzbasiertes Chunking

Das satzbasierte Chunking ist eine linguistisch fundierte Strategie zur Segmentierung von Texten, bei der die Chunk-Grenzen entlang vollständiger Sätze verlaufen. Jeder Chunk enthält genau einen oder mehrere abgeschlossene Sätze, wobei Satzgrenzen mithilfe sprachtechnologischer Werkzeuge automatisch erkannt werden. Diese Methode gilt als besonders robust, einfach implementierbar und zugleich semantisch stabil, da der natürliche Fluss der Sprache in der Regel erhalten bleibt.

4.6.1 Ziel und Funktionsweise

Ziel dieser Strategie ist es, eine möglichst kohärente und in sich geschlossene semantische Einheit zu erhalten – ohne den Text künstlich an Zeichen- oder Token-Limits zu zerschneiden. Da Sätze in sich abgeschlossene Gedanken- oder Informationseinheiten darstellen, eignet sich diese Methode besonders für Anwendungen, in denen inhaltlicher Zusammenhang, Lesbarkeit oder transparente Rückverfolgbarkeit eine Rolle spielen. Sie wird beispielsweise in der automatischen Textannotation, im LLM-basierten Frage-Antwort-System, bei semantischen Suchmaschinen oder zur Vorbereitung für Klassifizierungsaufgaben eingesetzt.

Die technische Umsetzung erfolgt in der Regel durch Satzsegmentierung, etwa mit Hilfe von NLP-Tools wie spaCy, Stanza, nltk oder LLM-integrierten Preprocessing-Methoden. Diese erkennen Satzenden zuverlässig anhand von Interpunktion, syntaktischen Mustern und statistischen Wahrscheinlichkeiten – auch in komplexeren Texten.

4.6.2 Vorteile und Grenzen

Die Vorteile des satzbasierten Chunkings liegen auf der Hand:

-

Inhaltliche Geschlossenheit durch syntaktisch vollständige Einheiten

-

Sprachliche Klarheit und Lesbarkeit

Allerdings ist die Methode nicht frei von Einschränkungen. In Texten mit sehr langen Sätzen – etwa literarischen Werken, juristischen Formulierungen oder wissenschaftlichen Abhandlungen – kann ein einzelner Satz leicht mehrere hundert Tokens umfassen und somit die Kontextgrenze eines Sprachmodells überschreiten. In solchen Fällen müssen ergänzende Strategien greifen, etwa eine zusätzliche Token-basierte Begrenzung oder rekursive Unterteilung in Teilinformationen. Umgekehrt enthalten sehr kurze Sätze oft zu wenig Kontext, was zu fragmentierten Chunks und suboptimalen Antworten führen kann.

Satzbasiertes Chunking stellt eine sprachlich fundierte und praktisch robuste Strategie dar, die sich in vielen Anwendungsfeldern bewährt hat – insbesondere dann, wenn semantischer Zusammenhang, interpretierbare Struktur und technische Einfachheit gleichermaßen wichtig sind. In der Praxis wird sie häufig als Basismethode eingesetzt, auf der komplexere Verfahren wie semantisches oder rekursives Chunking aufbauen.

4.7 Erweiterte Funktionalitäten in der Chunking-Praxis

Unabhängig von der zugrunde liegenden Chunking-Strategie – ob semantisch, satzbasiert, rekursiv oder dokumentbasiert – gibt es eine Reihe ergänzender Verfahren, welche die Leistungsfähigkeit, Kontexttreue und Flexibilität von Chunks deutlich erhöhen. Zu den wichtigsten gehören:

4.7.1 Overlapping (Überlappung)

Beim Overlapping wird ein Teil des vorhergehenden Chunks explizit in den nachfolgenden Chunk übernommen. Dies dient dazu, Kontextbrüche zu vermeiden und sicherzustellen, dass Übergänge inhaltlich nachvollziehbar bleiben – auch wenn Benutzeranfragen oder LLM-Modelle nur einen einzelnen Chunk verarbeiten.

Beispiel:

-

Chunk A: „... Gregor erwachte. Er lag auf dem Rücken und sah ...“

-

Chunk B: „Er lag auf dem Rücken und sah ... Seine Beine flimmerten ...“

Der Satz „Er lag auf dem Rücken ...“ kommt in beiden Chunks vor, um den semantischen Anschluss zu sichern.

4.7.2 Doppelung (Redundanz für Mehrfachverwendung)

Doppelung bedeutet, dass ein identischer Inhalt in mehreren Chunks vorkommt, um unterschiedlichen semantischen, technischen oder strukturellen Anforderungen gerecht zu werden. Dies ist besonders hilfreich, wenn ein Textteil sowohl mit als auch ohne Zusatzinformationen benötigt wird.

Beispiel:

Ein Abschnitt enthält eine Passage mit Fußnote:

„Bildung ist ein Menschenrecht¹.“

¹ Vgl. UNESCO, Bildung für alle, 2022.

Doppelung kann wie folgt erfolgen:

-

Chunk X (vollständig): enthält Text inklusive Fußnote

-

Chunk Y (gekürzt): enthält denselben Satz ohne Fußnote

Diese Redundanz ermöglicht sowohl präzise Verarbeitung als auch Rückverfolgbarkeit.

4.7.3 Referenzierung (Verknüpfung durch Metadaten)

Referenzierung meint die explizite semantische Verbindung von Chunks untereinander – z. B. wenn ein Begriff, Konzept oder Artikel in einem anderen Chunk erläutert oder angewendet wird. Solche Querverweise sind zentral für Navigation, semantisches Retrieval und kontextuelle Antwortgenerierung.

Die Umsetzung hängt jedoch stark von einer Vielzahl technischer Parameter ab:

-

LLMs oder regelbasierte Modelle, die semantische Zusammenhänge erkennen

-

Embedding-Software (z. B. FAISS, Weaviate), die Ähnlichkeiten zwischen Chunks berechnet

-

das Strukturformat der Daten: In Markdown sind Verweise explizit verlinkbar, in HTML über IDs und Anker, in TXT müssen zusätzliche Metadaten erzeugt werden

Beispiel für Metadaten-Referenzierung:

{

"chunk_id": 17,

"article": "Artikel 1",

"content": "Menschenwürde ist unantastbar.",

"metadata": {

"verweist_auf": "chunk_id_4",

"kontext": "Definition Menschenwürde",

"quelle": "Grundgesetz"

}

}Hier wird Chunk 17 mit einem definitorischen Chunk (ID 4) verknüpft, was eine semantische Rückverfolgung erlaubt.

4.7.4 Strategische Erkenntnisse

Diese erweiterten Verfahren – Overlapping, Doppelung und Referenzierung – sind integraler Bestandteil moderner Chunking-Architekturen. Sie wirken auf unterschiedlichen Ebenen: von technischer Anschlussfähigkeit über Redundanzmanagement bis hin zu semantischer Tiefenerschließung. In Kombination mit klassischen Strategien ermöglichen sie leistungsfähige, robuste und anwendungsspezifisch anpassbare Chunk-Systeme, insbesondere in komplexen Domänen wie Recht, Bildung, Wissenschaft und Verwaltung.

5 Embedding-Software

5.1 Funktionsweise von Embedding-Software in RAG-Systemen

In Retrieval-Augmented-Generation-(RAG-)Systemen ist Embedding-Software ein zentraler Baustein: Sie wandelt Textdaten in eine maschinenlesbare Form – sogenannte Vektoren – um, die semantische Bedeutung repräsentieren. Diese Transformation ist entscheidend, um externe Inhalte (z. B. literarische Texte) für KI-Systeme durchsuchbar und interpretierbar zu machen. Dieses Kapitel veranschaulicht die Funktionsweise von Embedding-Software in RAG-Systemen anhand eines literarischen Klassikers: „Die Verwandlung“ von Franz Kafka.

5.1.1 Vom literarischen Satz zum semantischen Vektor

Nehmen wir den berühmten ersten Satz aus „Die Verwandlung“:

„Als Gregor Samsa eines Morgens aus unruhigen Träumen erwachte, fand er sich in seinem Bett zu einem ungeheueren Ungeziefer verwandelt.“

Ein Embedding-Modell wie text-embedding-ada-002 (OpenAI) oder ein BERT-Derivat transformiert diesen Satz in einen mehrdimensionalen Vektor – z. B.:

[0.023, -0.785, 1.202, ..., -0.091]Dieser Vektor codiert nicht den Wortlaut, sondern die semantische Bedeutung des Satzes – etwa Themen wie „Identitätsverlust“, „Verwandlung“, „Albtraum“. Im Vektorraum liegen ähnliche Aussagen (z. B. aus anderen Werken mit motivischer Nähe) in räumlicher Nähe.

Diese Repräsentation erlaubt eine inhaltliche Suche, selbst wenn eine Anfrage die Formulierung stark verändert:

Frage: „In welcher Erzählung wird ein Mensch über Nacht zu einem Tier?“

Die Anfrage wird ebenfalls in einen Vektor übersetzt und mit gespeicherten Embeddings verglichen – der Kafka-Text wird als relevant erkannt, obwohl der Begriff „Gregor Samsa“ oder „Ungeziefer“ nicht genannt wurde.

5.1.2 Speicherung und semantische Suche in Vektordatenbanken

Der eingebettete Kafka-Satz wird in einer Vektordatenbank (z. B. FAISS, Pinecone, ChromaDB) abgelegt. Dort werden alle Chunks des Textes – z. B. Absätze, Szenen oder Kapitel – als einzelne Embeddings verwaltet.

Bei einer Anfrage an das System (z. B. durch einen Nutzer oder ein LLM) läuft folgende Pipeline ab:

-

Die Anfrage wird ebenfalls als Embedding erzeugt.

-

Semantische Ähnlichkeitssuche: Der Anfragen-Vektor wird mit gespeicherten Kafka-Vektoren verglichen.

-

Top-N-Ergebnisse: Die relevantesten Textstellen werden zurückgeliefert, etwa:„Was ist mit mir geschehen? dachte er. Es war kein Traum.“

(Kafka, „Die Verwandlung“)

Solche Treffer basieren nicht auf Schlüsselwörtern, sondern auf inhaltlicher Nähe im Vektorraum – eine deutliche Verbesserung gegenüber der klassischen Stichwortsuche.

5.1.3 Integration in RAG-Architekturen

Die relevanten Textstellen werden vom RAG-System (z. B. via LlamaIndex oder LangChain) an ein Sprachmodell (LLM) weitergegeben, das daraus eine Antwort generiert. Im Fall einer Kafka-Analyse könnte dies eine literaturwissenschaftlich fundierte Erläuterung sein, etwa:

„In Franz Kafkas ‚Die Verwandlung‘ thematisiert der erste Satz die existenzielle Krise der Hauptfigur Gregor Samsa. Die plötzliche Verwandlung in ein Ungeziefer steht symbolisch für soziale Entfremdung und Identitätsverlust.“

Hierbei stammen Hintergrund und Zitate aus dem eingebetteten Text, nicht aus dem Sprachmodell allein – die Embedding-Software macht den Text überhaupt erst nutzbar für die KI.

5.1.4 Implikationen für die Praxis

Am Beispiel von „Die Verwandlung“ zeigt sich: Embedding-Software ist der Schlüssel zur semantischen Erschließung komplexer, literarischer Inhalte. Sie ermöglicht es, nicht nur nach Begriffen, sondern nach Bedeutungen zu suchen – unabhängig von Sprache, Stil oder Struktur. In Verbindung mit dynamischem Chunking (z. B. absatzweise) und Metadaten-Anreicherung entsteht eine hochflexible, KI-taugliche Literaturdatenbank für RAG-Systeme.

5.2 Metadaten in Embedding-gestützten RAG-Systemen

5.2.1 Metadaten als semantische Verstärker

In RAG-Systemen sind Embeddings allein nicht immer ausreichend, um den Kontext eines Textes vollständig zu erfassen – insbesondere bei mehrdeutigen, literarischen oder domänenspezifischen Inhalten. Hier kommen Metadaten ins Spiel: strukturierte Zusatzinformationen, die einem Textstück zugeordnet werden, um Kontext, Herkunft, Struktur und Bedeutung maschinell nutzbar zu machen.

Beispiel aus „Die Verwandlung“:

{

"content": "Als Gregor Samsa eines Morgens ...",

"metadata": {

"autor": "Franz Kafka",

"titel": "Die Verwandlung",

"kapitel": 1,

"literaturgattung": "Erzählung",

"sprache": "de",

"entstehungsjahr": 1912

}

}Diese Metadaten werden nicht eingebettet, sondern separat gespeichert, z. B. als JSON oder RDF. Sie können beim Filtern, Sortieren oder gezielten Prompt-Engineering eingesetzt werden – etwa um „nur deutschsprachige Literatur der Moderne mit surrealem Motiv“ zu durchsuchen.

5.2.2 Wie Metadaten mit Embedding-Software zusammenspielen

Obwohl Metadaten nicht direkt in den Embedding-Vektor eingehen, beeinflussen sie:

-

Chunking (z. B. Trennung nach Kapiteln, Szenen, Sprecherrollen)

-

Retrieval-Filter (z. B. nur Inhalte von „Kafka“ oder mit „Kapitel ≥ 3“)

-

Antwortkontext für LLMs (z. B. „Der folgende Abschnitt stammt aus einer expressionistischen Erzählung von 1912 ...“)

Beim Suchen wird häufig ein hybrides Verfahren verwendet:

-

Semantische Suche: mittels Embeddings

-

Symbolische Filterung: mittels Metadaten-Abfrage (z. B. WHERE author = "Kafka")

5.2.3 Unterschiede zwischen Embedding-Software im Umgang mit Metadaten

Je nach System gibt es große Unterschiede, wie gut Metadaten unterstützt oder integriert werden:

|

Embedding-System |

Metadatenverarbeitung |

Besonderheiten |

|

OpenAI Embeddings |

keine native Metadatenbindung |

Trennung von Vektor & Info notwendig |

|

ChromaDB |

Native Metadaten-Felder |

Integrierte Filterung über .where() |

|

Weaviate |

Vollständig semantisch + symbolisch |

Graph-Struktur mit Schema |

|

FAISS |

Nur Vektorähnlichkeit |

Metadaten müssen extern verwaltet werden |

|

Qdrant |

JSON-basierte Metadaten |

Unterstützt Tags, Scores, Filter |

Einige Systeme wie ChromaDB oder Weaviate erlauben es, Embeddings und strukturierte Metadaten gemeinsam abzufragen, z. B. durch eine Abfrage wie:

db.query(

query_vector=embedding,

filter={"autor": "Kafka", "kapitel": {"$gte": 2}},

top_k=5

)Diese Integration macht die Suche nicht nur semantisch, sondern auch kontextbewusst.

5.2.4 Zusammenfassung

Metadaten erweitern Embedding-Software um eine symbolische Ebene, die semantische Vektorräume mit strukturierter, kontextueller Bedeutung anreichert. Während Embeddings Nähe und Relevanz erkennen, liefern Metadaten Navigations- und Steuerungspunkte innerhalb komplexer Textkorpora. Wer RAG-Systeme robust und transparent bauen will – insbesondere im literarischen, wissenschaftlichen oder juristischen Bereich – sollte beide Welten integriert denken.

Hinweis: Mehr Aspekte zum Metadaten-Thema werden in Teil III der RAG-Studienreihe mit dem Titel „Automatisierte Chunks und XML: Vom PDF zum flexiblen RAG-System“ erläutert.

5.3 Der Ablauf in einem RAG-System

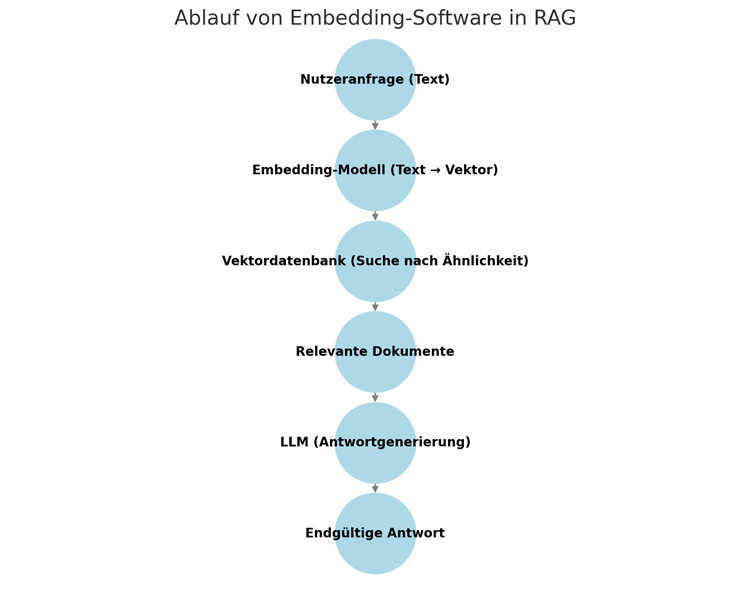

Der Einsatz von Embedding-Software ist ein zentrales Element in modernen Retrieval-Augmented-Generation-(RAG-)Systemen. Die folgende Abbildung zeigt den typischen Ablauf einer solchen Pipeline – von der Nutzeranfrage bis zur KI-generierten Antwort – und verdeutlicht die Rolle der einzelnen Komponenten in der Verarbeitungskette.

1. Nutzeranfrage (Text)

Am Anfang steht eine natürliche Spracheingabe durch den Nutzer, etwa in Form einer Frage oder Suchanfrage. Diese Eingabe dient als Ausgangspunkt für die nachfolgenden Verarbeitungsschritte.

2. Embedding-Modell (Text → Vektor)

Der eingegebene Text wird mithilfe eines Embedding-Modells in einen mehrdimensionalen Vektor übersetzt. Dieser Vektor repräsentiert die semantische Bedeutung der Anfrage und ist Grundlage für die Ähnlichkeitssuche. Verwendet werden Modelle wie z. B. text-embedding-ada-002 von OpenAI oder BERT-Varianten, die den Text als Zahlenraum (Vektorraum) abbilden.

3. Vektordatenbank (Suche nach Ähnlichkeit)

Die erzeugten Vektoren werden mit den Einträgen in einer Vektordatenbank (z. B. FAISS, Weaviate, Pinecone) verglichen. Hier befinden sich bereits vorab eingebettete Textabschnitte (Chunks), die aus vorhandenen Dokumenten erzeugt wurden. Ziel ist es, jene Chunks zu identifizieren, die inhaltlich ähnlich zur Anfrage sind.

4. Relevante Dokumente

Als Ergebnis des Vektorvergleichs werden die semantisch nächstliegenden Chunks abgerufen. Sie enthalten die für die Nutzerfrage potenziell relevanten Informationen. In diesem Schritt entscheidet sich, wie präzise und vollständig das LLM antworten kann – je nachdem, ob die richtigen Dokumentpassagen gefunden wurden.

5. LLM (Antwortgenerierung)

Die ausgewählten Dokumente werden zusammen mit der ursprünglichen Anfrage an ein Large Language Model (LLM) übergeben. Dieses nutzt den externen Kontext, um eine fundierte Antwort zu formulieren – also nicht aus reinem Training, sondern auf Basis der eingebetteten Informationen. Der RAG-Prozess kombiniert somit Suchmaschine und generative KI.

6. Endgültige Antwort

Am Ende steht die vom LLM generierte endgültige Antwort, die dem Nutzer angezeigt wird. Sie basiert auf einer Mischung aus abrufbarem Wissen (retrieved) und sprachlicher Formulierungskompetenz (generated) – daher der Name Retrieval-Augmented Generation.

5.4 Vergleich von Chunking-Strategien im Hinblick auf Struktur, Kontext und Anwendbarkeit

Die folgende Tabelle bietet eine systematische Übersicht über zentrale Chunking-Strategien im Kontext von Retrieval-Augmented Generation (RAG). Dabei werden die Verfahren hinsichtlich ihrer Segmentierungslogik, der Fähigkeit zum Kontexterhalt, ihrer Eignung für komplexe Inhalte sowie ihres technischen Aufwands miteinander verglichen. Diese komparative Darstellung soll helfen, geeignete Strategien für spezifische Anwendungsbereiche (z. B. normativer Text, technische Dokumentation, Bildung) gezielt auszuwählen.

|

Kategorie |

Entscheidungspunkte |

Optionen/Details |

|

Datenstruktur in den Chunks |

Format der Inhalte im Chunk |

Markdown, Plain Text, HTML, XML, JSON |

|

Strukturierte vs. unstrukturierte Daten |

Tabellen, Listen, Fließtext |

|

|

Metadaten im Chunk |

Quellenangaben, Zeitstempel, Kategorien |

|

|

Dateiformat der Chunks |

Dateiformat zur Speicherung |

JSON, YAML, TXT, CSV, XML |

|

Kompressionsstrategie |

Gzip, Bzip2, keine Komprimierung |

|

|

Optimierung für LLMs |

Anpassung an spezifische Modelle |

|

|

Codierungsstrategie |

Semantische Kodierung |

Embeddings mit Zusatzinfos (z.B. Tags) |

|

Referenzierung von Inhalten |

IDs, Hyperlinks, Fußnoten |

|

|

Kontextualisierung |

Annotationen, zusätzliche Metainformationen |

|

|

Chunking-Strategie |

Chunk-Größe |

Feste Länge, feste Token-Anzahl, dynamisch |

|

Überlappung von Chunks |

Keine, teilweise, adaptive Überlappung |

|

|

Token-Limits beachten |

Ja (optimiert für LLM-Grenzen) / Nein |

|

|

Embedding-Software |

Auswahl des Embedding-Modells |

OpenAI, BERT, Cohere, SentenceTransformers |

|

Preprocessing & Tokenisierung |

Stoppwörter entfernen, Lemmatisierung |

|

|

Feinabstimmung der Embeddings |

Domänenspezifisches Training |

|

|

Vektordatenbank |

Auswahl der Datenbank |

Pinecone, Weaviate, FAISS, Chroma, Milvus |

|

Indexierungsstrategie |

Flat, HNSW, IVF, PQ |

|

|

Skalierbarkeit |

Cloudbasiert, On-Premise, Hybrid |

|

|

LLM (Large Language Model) |

Auswahl des LLM |

GPT-4, Claude, Mistral, LLaMA, Custom |

|

Feinabstimmung des Modells |

Ja (Feintuning), Nein (Standardmodell) |

|

|

Anwendungsfälle |

Allgemein, Fachspezifisch, Code, Medizin |

|

|

Evaluation & Monitoring |

Evaluationsmetriken |

Genauigkeit, Relevanz, Latency, Recall |

|

Nutzerfeedback einbeziehen |

Ja, Nein |

|

|

Kontinuierliche Optimierung |

Automatisiert, Manuell |

6 Vom Durcheinander zur Struktur – Problemräume im RAG-System und eine Fallstudie zur Klärung

6.1 Erkenntnisse aus Teil 1 der RAG-Studienreihe

Die wichtigste Erkenntnis aus Teil 1 der RAG-Studienreihe mit dem Titel „Strukturierte vs. unstrukturierte Daten für RAG-Training: ein Vergleich“ lässt sich in einem Satz zusammenfassen: Struktur der Daten ist entscheidend für die Qualität eines RAG-Systems. Besonders beim Vergleich strukturierter Formate, wie Markdown oder HTML, mit unstrukturierten PDFs zeigte sich, dass die Modell-Antworten präziser und fundierter ausfallen, wenn die zugrunde liegenden Inhalte klar gegliedert und mit Metadaten angereichert sind.

6.2 Zielsetzung: Ordnung schaffen durch eine Fallstudie

Statt nun theoretisch eine Systematik über mögliche Problemräume zu entwerfen, wollen wir eine prototypische Fallstudie nutzen, um die bisherigen Inhalte zu strukturieren. Anhand eines konkreten, realitätsnahen Szenarios können wir zeigen, wie die einzelnen Aspekte – Strukturformate, Chunking, Metadaten, Referenzen und Modell-Integration – in einer kohärenten Pipeline zusammenwirken.

Diese Fallstudie wird uns helfen, das "Durcheinander" an technischen Möglichkeiten, Strategien und Abhängigkeiten zu entwirren und in sinnvolle, lösungsorientierte Handlungskomplexe zu überführen.

6.3 Fallstudie: Herausforderungen bei der RAG-Implementierung in einem Wissenschaftsverlag

Ein mittelgroßer Wissenschaftsverlag mit einem Portfolio von über 50 fachspezifischen, KI-gestützten Chatbots steht vor der Aufgabe, eine konsistente und erweiterbare RAG-Infrastruktur aufzubauen. Die Datenlage im Verlag ist historisch gewachsen und stellt verschiedene technische und konzeptionelle Herausforderungen dar.

Ein Großteil der Inhalte liegt im XML-Format vor – insbesondere nach den Standards BITS und JATS. Diese Formate sind reich strukturiert, allerdings existieren viele ältere Titel ausschließlich als unstrukturierte PDF-Dateien. Darüber hinaus wurden Teile des XML-Bestands in verschiedene Ausgabeformate wie PDF und ePub überführt, was zu Mehrdeutigkeiten und Inkonsistenzen führt. Der heterogene Formatmix erschwert die einheitliche Erschließung der Inhalte für RAG-Prozesse erheblich.

Zusätzlich ist der Content-Durchsatz dynamisch: Es erscheinen regelmäßig neue Publikationen, während veraltete Ausgaben entfernt oder durch neue ersetzt werden müssen. Dabei entstehen Anforderungen an eine kontinuierliche Inhaltsaktualisierung, automatisierte Versionierung und Synchronisation der Dokumentbasis – ohne Redundanzen oder Zugriff auf veraltete Inhalte.

Ein zentrales Problem ist die Abhängigkeit von spezifischen LLM-Anbietern. Der Verlag möchte eine Lösung, die langfristig unabhängig bleibt, doch viele bestehende Systeme sind stark an proprietäre Modelle gekoppelt. Der Wunsch nach technischer und wirtschaftlicher Flexibilität kollidiert mit den proprietären Standards einiger Anbieter (z. B. für Tokenisierung oder Kontextlimits).

Ein weiteres Problem betrifft die Zukunftssicherheit: Da sich die Anforderungen neuer LLMs – etwa hinsichtlich Chunk-Größe, Semantik oder Kontextfenster – nicht vorhersagen lassen, ist unklar, wie stabil die heute entwickelten Datenprozesse in zwei oder drei Jahren noch funktionieren werden. Eine starre Architektur könnte später zu kostspieligen Anpassungen führen, falls neue Modelle mit völlig anderen Anforderungen eingeführt werden.

Zudem ist nicht eindeutig geklärt, wie Inhalte so gechunkt werden können, dass sie sowohl für aktuelle LLMs als auch für künftige Modellgenerationen optimal nutzbar bleiben – insbesondere, wenn es um wissenschaftlich komplexe Texte mit Querverweisen, Fußnoten, Tabellen oder mehrsprachigen Abschnitten geht.

7 Struktur und Haltung von Daten – zwei fundamentale Dimensionen der Fallstudie

7.1 Ein Schritt zurück: Zwei Kernprobleme statt vieler Einzelfragen

Um das sehr komplexe Gesamtproblem rund um Retrieval-Augmented Generation (RAG) besser fassen zu können, hilft es, einen analytischen Schritt zurückzugehen. Aus der Praxis wie auch der Theorie kristallisieren sich dabei zwei fundamentale Problemfelder heraus, die – sauber getrennt – die Basis jeder nachhaltigen RAG-Strategie bilden:

-

Datenstrukturierung

-

Datenhaltung

Diese Trennung ist nicht nur analytisch sinnvoll, sondern auch praktisch notwendig, wenn man technologische Unabhängigkeit und langfristige Wartbarkeit erreichen will.

7.2 Datenstrukturierung: Chunk-neutral und medienneutral

In der Praxis der automatisierten Medienproduktion ist das Strukturproblem altbekannt. Wer heute Inhalte für Print, ePub, InDesign, PDF, Web oder App aufbereiten muss, weiß: Nur eine medienneutrale Datenstrukturierung macht flexible Wiederverwendung möglich. Genau hier liegt der Kern der Lösung – auch für RAG.

Die Antwort lautet: Chunk-neutrale Strukturierung.

Wir verzichten auf eine Vorstrukturierung in konkrete Chunks (z. B. 300 Tokens oder 500 Zeichen), sondern halten die Inhalte in einem chunk-neutralen Format, das beliebige Chunking-Strategien automatisch generieren kann. Dieses Format erlaubt es, später jederzeit kontextabhängig die passende Chunk-Form zu erzeugen – sei es Token-basiert für GPT, absatzweise für BERT oder mit Overlapping für spezielle Suchanwendungen.

Technologischer Kern:

-

XML als etabliertes, medienneutrales Format bleibt auch hier die Basis in Form eines HUB-/Pivot-Formats.

-

Hinzu kommen nun Technologien wie:

-

XSLT zur regelbasierten Transformation,

-

Python zur Erzeugung von Tokens, u.v.m.,

-

XProc zur Erstellung einer orchestrierten Verarbeitungspipeline,

-

XQuery zur Verarbeitung sehr großer Datenformate und für Auswertungen,

-

lokale LLMs zur inhaltlichen Anreicherung oder Klassifikation,

-

sowie XML-Datenbanken.

-

Das Zusammenspiel dieser Werkzeuge ist komplex, aber bekannt und beherrschbar – besonders in Umfeldern, die mit Crossmedia-Publishing oder technischer Dokumentation vertraut sind.

7.3 Datenhaltung: Flexibel, semantisch und automatisiert

Auch die Frage, wo und wie die strukturierten Inhalte gespeichert werden, ist entscheidend. Die Anforderungen sind hoch:

-

Versionierbarkeit,

-

semantische Durchsuchbarkeit,

-

effiziente Integration in nachgelagerte RAG-Prozesse,

-

Automatisierung von Updates (z. B. bei neuen Ausgaben),

-

und technologische Offenheit.

Die Lösung liegt in Content Delivery Services (CDS), wie sie sich in der Technischen Dokumentation längst bewährt haben.

Zentrale Konzepte:

-

Speicherung strukturierter Inhalte in container-basierten Formaten (z. B. ZIP+XML, METS, iiRDS),

-

Anreicherung mit RDF-Metadaten für semantische Erschließung,

-

SPARQL-fähige Systeme zur gezielten Abfrage von Inhalten,

-

Integration mit Git, CMS oder XML-Datenbanken, je nach Redaktionsumgebung.

Auch hier ist die Trennung von Struktur und Haltung der Daten entscheidend: Die Inhalte bleiben unabhängig von der konkreten Ausgabeform und der konkreten LLM-/Embedding-Kombination. So lässt sich jederzeit wechseln – sei es zu einem neuen Sprachmodell, einer anderen Vektordatenbank oder einer anderen Darstellungsform.

8 Ausblick – Die nächsten Schritte der RAG-Forschung

Mit diesem Kapitel schließen wir die aktuelle Phase der Studie ab, in der wir den Grundstein für ein systematisches Verständnis von RAG-Systemen gelegt haben. Wir haben erkannt, dass die Qualität und Zukunftsfähigkeit solcher Systeme im Wesentlichen von zwei Faktoren abhängen: der Strukturierung der Daten und ihrer Haltung innerhalb eines flexiblen, automatisierten Ökosystems.

Um die komplexen Erkenntnisse aus der Fallstudie weiter zu vertiefen und konkret nutzbar zu machen, folgen zwei vertiefende Einzelstudien, die jeweils einen dieser beiden zentralen Bereiche ins Zentrum rücken.

8.1 Nächste Studie: Datenstrukturierung und automatisiertes Chunking

Die erste kommende Studie wird sich ausschließlich der Frage widmen, wie wir Inhalte medienneutral strukturieren und daraus automatisiert alle erdenklichen Chunk-Formate ableiten können – sowohl für bestehende als auch zukünftige LLM-Systeme.

Ziel ist es, eine vollautomatische Infrastruktur zu entwickeln, die beliebige Chunking-Strategien (Tokens, Wörter, Absätze, Kapitel, semantische Einheiten usw.) auf Knopfdruck generieren kann – angepasst an die jeweiligen Anforderungen von Modell, Anwendung oder Nutzeroberfläche.

Ein zentrales Werkzeug in diesem Zusammenhang wird Octopus sein – eine leistungsstarke Lösung zur Konvertierung unterschiedlichster Quellformate (z. B. HTML, ePub, Word, InDesign, PDF) in ein chunk-neutrales, medienneutrales Zwischenformat. Damit wird es erstmals möglich, auch aus schwer verarbeitbaren Formaten wie PDF systematisch strukturierte, RAG-taugliche Inhalte zu extrahieren – automatisiert, skalierbar und standardkonform.

8.2 Letzte Studie der Reihe: Zusammenarbeit mit einem Content Delivery Service (CDS)

Die abschließende Studie wird sich mit der Frage beschäftigen, welche Rolle ein Content Delivery Service (CDS) in der Gesamtarchitektur eines RAG-Systems spielt – insbesondere in der Schnittstelle zwischen strukturierten Inhalten und den Retrieval- und Generierungskomponenten.

Im Mittelpunkt steht die Kommunikation zwischen CDS und RAG:

-

Wie fordern LLMs gezielt Inhalte aus dem CDS an?

-

Wie werden RDF-Metadaten, SPARQL-Abfragen und Container-Formate (z. B. iiRDS) zur Inhaltsselektion genutzt?

-

Wie lassen sich Updates, Versionierungen und Modellwechsel automatisieren und absichern?

Ziel ist es, ein intelligentes, regelbasiertes System zu schaffen, in dem die Datenhaltung nicht nur ein passiver Speicher, sondern ein aktiver Akteur im RAG-Workflow ist – mit semantischem Verständnis, Rückkanälen zur Bewertung der Modellantworten und Integrationen in bestehende Publishing- und Redaktionssysteme.