Teil 1 der RAG-Studienreihe: Strukturierte vs. unstrukturierte Daten für RAG-Training – ein Vergleich

Einleitung

Kurzbeschreibung dieser Studie

Diese Studie untersucht, ob strukturierte oder unstrukturierte Daten besser für das Training eines RAG-Systems (Retrieval-Augmented Generation) geeignet sind. RAG-Systeme kombinieren vortrainierte Sprachmodelle mit einer externen Wissensquelle, um genauere und kontextbezogene Antworten zu generieren. Eine zentrale Frage dabei ist, welches Datenformat die besten Ergebnisse liefert.

Dafür wurden drei verschiedene RAG-Systeme entwickelt, die auf derselben Wissensbasis, aber mit unterschiedlichen Datenformaten trainiert wurden. Anschließend wurden ihnen elf identische Fragen gestellt, um zu analysieren, ob sich die Antworten je nach Datenformat unterscheiden und welches Format die besten Ergebnisse erzielt.

Studienergebnisse

Die Tests zeigten eindeutig, dass strukturierte Daten einem unstrukturierten PDF in jedem Fall überlegen sind. Besonders gut schnitten speziell für das RAG-System aufbereitete Daten ab. Das beste Ergebnis wurde mit einem Markdown-Format erzielt, das eine klare Strukturierung der Informationen ermöglichte. Dadurch wurden nicht nur präzisere, sondern auch konsistentere Antworten generiert.

Die Ergebnisse der Tests finden Sie in diesem Ordner in der Exceldatei: Zu den Unterlagen

|

Kategorien |

HTML Richtig |

PDF Richtig |

MD Richtig |

|---|---|---|---|

|

1 |

0 |

1 |

|

|

Literaturverzeichnis |

0 |

0 |

1 |

|

Endnote |

1 |

0 |

1 |

|

Tabellen |

1 |

1 |

2 |

|

Auszeichnungen |

0 |

0 |

0 |

|

Layout |

3 |

1 |

3 |

|

Semantik Mathe |

1 |

1 |

1 |

|

Index |

1 |

0 |

1 |

|

Summe |

8 |

3 |

10 |

Fazit

Diese Studie bestätigt, dass eine gezielte Strukturierung der Daten die Leistung eines RAG-Systems erheblich verbessert. Für optimale Ergebnisse sollten die Daten in einem Format vorliegen, das speziell für das RAG-System angepasst ist – idealerweise in Markdown oder einem vergleichbaren strukturierten Format.

1 Methodik der Untersuchung

1.1 Motivation

Mit der Weiterentwicklung von Retrieval-Augmented-Generation-(RAG)Systemen rückt die Frage in den Fokus, welche strukturierten Informationen aus Dokumenten bei der Konvertierung in Plain Text verloren gehen – und welche Auswirkungen dies auf die Nutzung und Qualität der generierten Antworten hat?

Während KI-Entwickler, die RAG-Systeme betreiben, in der Regel mit Python und datengetriebenen Prozessen vertraut sind, stammen die Inhalte oft von Fachexperten, die sich mit strukturierten Dokumentenformaten wie XML, Word oder PDF auskennen. Diese unterschiedlichen Perspektiven führen zu Herausforderungen in der Datenaufbereitung und -nutzung.

Sprachmodelle werden auf Basis großer Textmengen trainiert, die durch verschiedene Bibliotheken in Plain Text überführt werden. Dabei gehen oft wertvolle Metadaten und Strukturinformationen verloren. Dieser Verlust kann die Genauigkeit und Relevanz der Antworten beeinflussen, da RAG-Systeme typischerweise die Nähe von Textpassagen als Indikator für deren inhaltlichen Zusammenhang verwenden.

1.2 Untersuchung der Informationsverluste in strukturierten Dokumenten

In dieser Studie analysieren wir, welche strukturierten Informationen bei der Konvertierung von Dokumenten in Plain Text verloren gehen und welche Auswirkungen dies auf die Generierung von Antworten durch RAG-Systeme hat. Besonders im Fokus stehen Verweis-Systeme, Tabellen, typografische Auszeichnungen sowie unterschiedliche Layout- und Semantik-Strukturen.

Wir haben CustomGPT als LLM verwendet. Dabei handelt es sich um ein anpassbares GPT-Modell, das gezielt mit eigenen Inhalten und Datenquellen kombiniert werden kann, um domänenspezifische Antworten zu generieren. Es ermöglicht eine einfache Integration von Retrieval-Augmented Generation (RAG) in spezifischen Anwendungsszenarien.

Wir haben einen einfachen, aber typischen Zugang zu dem Thema gewählt, um praxisnahe Herausforderungen bei der Informationsübertragung aus strukturierten Dokumenten verständlich zu machen.

In den weiteren Studien dieser Reihe gehen wir differenzierter vor, analysieren die Architektur von RAG-Systemen im Detail und untersuchen systematisch die Ursachen für qualitative Unterschiede in den Antwortgenerierungen.

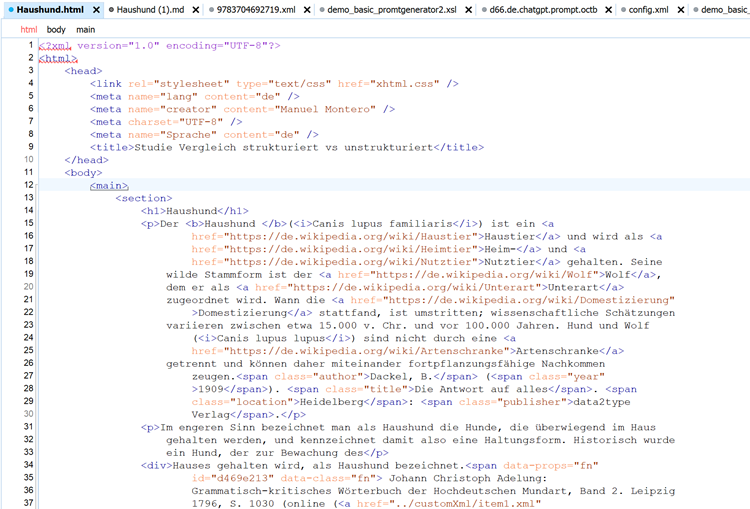

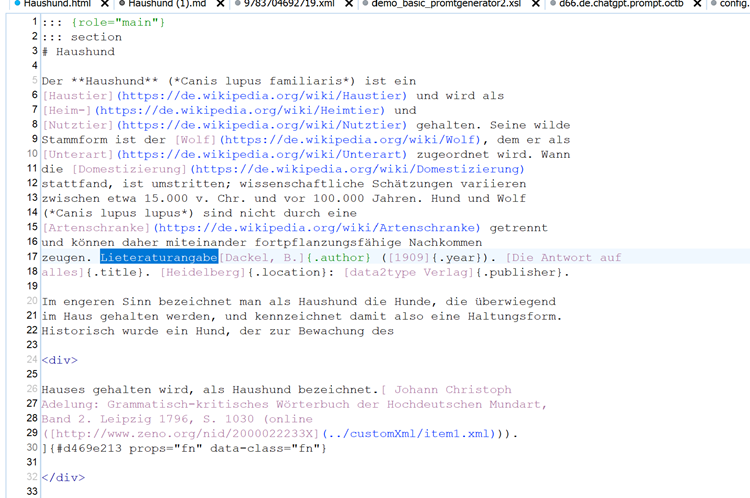

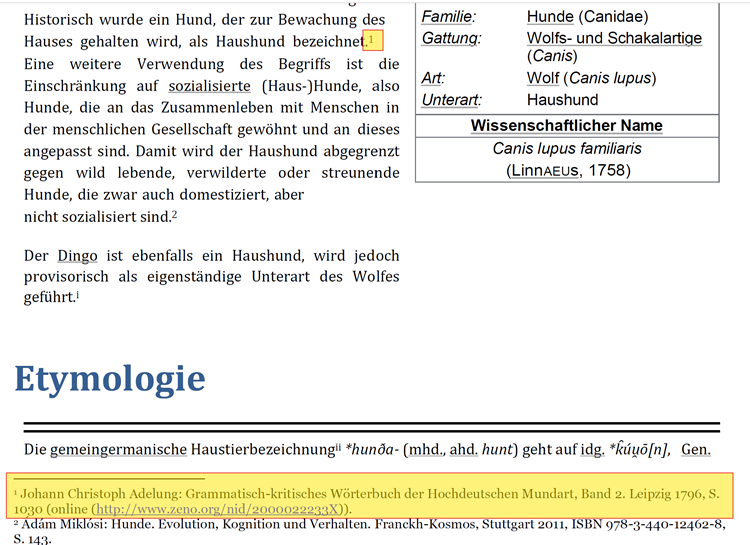

1.2.1 Verweis-Systeme: Fußnoten, Endnoten, Literaturverzeichnisse und Indexe

Ein wesentlicher Bestandteil wissenschaftlicher und technischer Dokumente sind Verweis-Systeme, die es ermöglichen, Informationen strukturiert miteinander zu verknüpfen.

Fußnoten sind Verweise innerhalb eines Dokuments, die zusätzliche Informationen oder Quellenangaben enthalten. In PDFs werden sie durch hochgestellte Zahlen oder Symbole markiert, die mit den entsprechenden Anmerkungen am Seitenende verknüpft sind. In XML-basierten Formaten hingegen sind Fußnoten oft direkt an der relevanten Textstelle hinterlegt, sodass ihr Kontext inhaltlich eng mit dem Haupttext verbunden bleibt.

Bei der Konvertierung aus PDF in Plain Text gehen diese expliziten Verknüpfungen verloren, wodurch der Bezug zwischen der Fußnote und der markierten Textstelle nicht mehr eindeutig ist.

Endnoten funktionieren ähnlich wie Fußnoten, befinden sich jedoch gesammelt am Ende eines Dokuments oder Kapitels. Die Verknüpfungen sind in strukturierten Dokumenten klar definiert, gehen jedoch im Plain Text meist verloren oder erscheinen nur als unstrukturierte Liste.

Indizes dienen als Verschlagwortungssystem und enthalten Metadaten zu einem Dokument, um gezielte Suchen oder Querverweise zu ermöglichen. In strukturierten Formaten wie XML oder PDF sind sie mit den relevanten Seitenzahlen oder Abschnitten verknüpft.

Nach der Umwandlung in Plain Text bleibt meist nur eine einfache Liste von Begriffen zurück, ohne die ursprünglichen Verknüpfungen. Dadurch wird der semantische Nutzen stark eingeschränkt.

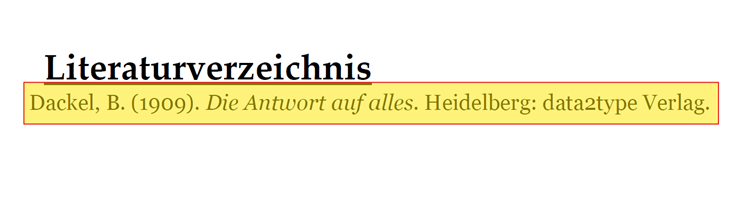

Literaturverzeichnisse enthalten bibliografische Angaben zu den zitierten Werken. In XML oder strukturierten Textformaten sind sie oft in einer spezifischen Zitierstruktur hinterlegt und mit den Zitaten im Text verknüpft.

In Plain Text können die Verknüpfungen zwischen Zitat und Quelle verloren gehen, wodurch die Nachvollziehbarkeit wissenschaftlicher Argumentationen erschwert wird.

1.2.2 Tabellen und ihre Struktur

Tabellen enthalten nicht nur Daten, sondern stellen durch ihre Struktur logische Zusammenhänge her.

In strukturierten Formaten (z. B. XML, HTML, Markdown) sind Tabellen durch explizite Tags definiert, die Zeilen und Spalten abgrenzen.

In PDFs können Tabellen als Rastergrafik oder eingebettete Struktur vorliegen.

In Plain Text gehen Spalten- und Zeilenbezüge oft verloren oder werden durch unstrukturierte Listen ersetzt.

RAG-Systeme können aus unstrukturierten Textdarstellungen keine klaren Tabellenbeziehungen extrahieren, wodurch bedeutende semantische Informationen verloren gehen.

1.2.3 Typografische und inzeilige Auszeichnungen

Textauszeichnungen wie Fettdruck, Kursivschrift, Unterstreichungen oder farbliche Markierungen tragen wesentlich zur Bedeutung eines Textes bei. Sie heben Schlüsselbegriffe hervor, zeigen Hierarchien oder kennzeichnen wichtige Passagen.

Plain Text ignoriert solche Markierungen weitgehend, wodurch wichtige Kontextinformationen und Betonungen verloren gehen. Besonders problematisch ist dies, wenn Begriffe oder Definitionen durch Formatierungen hervorgehoben wurden.

1.2.4 Layout: Textdarstellung und visuelle Struktur

Das Layout eines Dokuments spielt eine entscheidende Rolle bei der Lesbarkeit und Strukturierung von Informationen. In strukturierten Formaten wie XML, HTML oder PDF können Texte durch verschiedene gestalterische Mittel hervorgehoben werden. Hierfür wurden in den Tests verschiedene gestalterische Mittel kombiniert.

1.2.5 Semantik: Beispiel Mathematikformeln

Ein besonders kritischer Bereich sind semantische Strukturen, die spezifische Bedeutungen tragen, wie z. B. Mathematikformeln.

1.3 Ablauf der Analyse

-

Zur Durchführung der Analyse wurde ein spezielles Beispieldokument in drei Formaten – PDF, HTML und Markdown – erstellt, das dieselbe Wissensbasis enthält. Die Dokumentgröße war in diesem Fall irrelevant – es umfasste etwa 10 Seiten. Wichtiger waren die klare Struktur und Eindeutigkeit der Texte, um die Antwort leicht überprüfbar zu machen. Dies ermöglicht einen direkten Vergleich der Informationsverluste zwischen den Formaten und deren Auswirkungen auf RAG-Systeme.

-

Um die praktischen Auswirkungen dieser Verluste zu bewerten, wurden drei RAG-basierte Systeme auf der identischen technischen Grundlage trainiert, jeweils mit einem Dokument aus einem der drei Formate.

-

Anschließend wurden die trainierten RAG-Bots mit gezielten Fragen aus den untersuchten Bereichen konfrontiert, darunter Verweis-Systeme (Fußnoten, Endnoten, Literaturverzeichnisse, Indizes), Tabellenstrukturen, Layout- und Semantikmerkmale.

-

Die generierten Antworten wurden systematisch auf ihre Korrektheit überprüft, um festzustellen, inwieweit die strukturierten Informationen erhalten blieben und ob Unterschiede zwischen den Formaten messbare Auswirkungen auf die Antwortqualität hatten.

-

Jede gestellte Frage und die jeweilige Antwort der drei Bots wurden gespeichert und bleiben dauerhaft abrufbar. Dies ermöglicht eine detaillierte Analyse der Ergebnisse und erlaubt es auch Dritten, die generierten Antworten selbst zu überprüfen und eigene Tests durchzuführen. Die gespeicherten Antworten bieten somit eine transparente Grundlage für die Bewertung der Auswirkungen von Formatunterschieden auf RAG-Systeme.

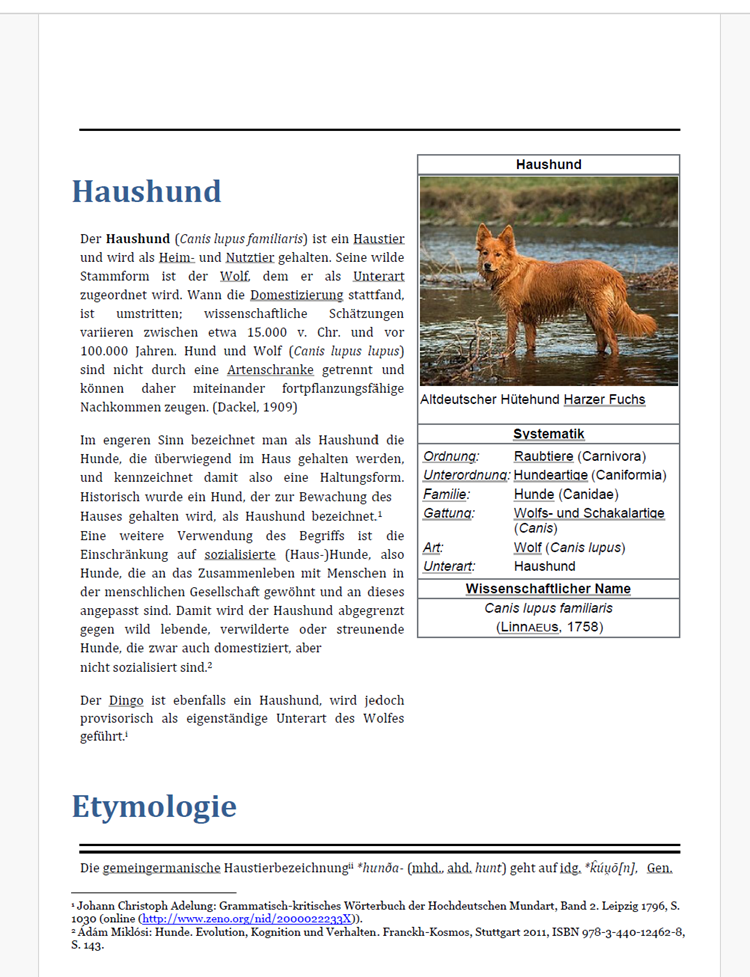

2 Die Datenbasis

Die drei Dokumentformate (PDF, HTML, Markdown) liegen dieser Studie bei und können für eigene Analysen herangezogen werden.

3 Die Aufgaben

Im Folgenden werden die verschiedenen Dokument-Strukturen, die zugrunde liegenden Problemstellungen und die Fragestellungen an das RAG-System einzeln vorgestellt.

3.1 Fußnoten

Die Frage hier lautet:

Wo wurde ein Hund, der zur Bewachung des Hauses gehalten wird, als Haushund bezeichnet?

Erkannt werden muss der Zusammenhang zwischen Text und Fußnote.

Ergebnis:

|

RAG |

Beurteilung |

Text |

Link |

Anmerkungen |

|

|

falsch |

Ein Hund, der zur Bewachung des Hauses gehalten wird, wurde historisch als Haushund bezeichnet 1. |

- |

|

|

MD |

richtig |

Ein Hund, der zur Bewachung des Hauses gehalten wird, wurde historisch als Haushund bezeichnet. Dies ist dokumentiert in Johann Christoph Adelungs "Grammatisch-kritisches Wörterbuch der Hochdeutschen Mundart, Band 2", Leipzig 1796, S. 1030. Die Quelle ist online verfügbar unter: http://www.zeno.org/nid/2000022233X 1. |

- |

|

|

HTML |

richtig |

Ein Hund, der zur Bewachung des Hauses gehalten wird, wurde historisch als Haushund bezeichnet. Dies ist dokumentiert in Johann Christoph Adelungs "Grammatisch-kritisches Wörterbuch der Hochdeutschen Mundart, Band 2", Leipzig 1796, S. 1030. Die Quelle ist online verfügbar unter: http://www.zeno.org/nid/2000022233X 1. |

- |

3.2 Literaturverzeichnis

Die Frage lautet:

Wo finde ich weitere Literatur zur Nachkommenschaft von Hund und Wolf?

Erkannt werden muss der Zusammenhang zwischen Text und Literaturverzeichnis.

Ergebnis:

|

RAG |

Beurteilung |

Text |

Link |

Anmerkungen |

|

|

falsch |

Weitere Literatur zur Nachkommenschaft von Hund und Wolf findest du in der Quelle von W. Christopher Wozencraft: Order Carnivora. Diese ist enthalten in: Don E. Wilson, DeeAnn M. Reeder (Hrsg.): Mammal Species of the World: A Taxonomic and Geographic Reference, 3. Auflage, The Johns Hopkins University Press, Baltimore 2005, ISBN 0-8018-8221-4, S. 532–628. Ein direkter Link zur Quelle ist hier verfügbar: https://www.departments.bucknell.edu/biology/resources/msw3/browse.asp?id=14000738 1. |

- |

|

|

MD |

richtig |

In meiner Wissensbasis wird eine Literaturangabe erwähnt, die sich mit dem Thema Hund und Wolf befasst: Dackel, B. (1909). Die Antwort auf alles. Heidelberg: data2type Verlag .Diese Quelle könnte weitere Informationen zur Nachkommenschaft von Hund und Wolf enthalten. |

- |

|

|

HTML |

falsch |

Weitere Literatur zur Nachkommenschaft von Hund und Wolf kann in der Quelle von W. Christopher Wozencraft gefunden werden. Diese ist in "Order Carnivora" enthalten, das in "Mammal Species of the World: A Taxonomic and Geographic Reference" (3. Auflage, The Johns Hopkins University Press, Baltimore, 2005) veröffentlicht wurde. Die spezifische Seite ist S. 532–628. Ein direkter Link zur Quelle ist hier angegeben: https://www.departments.bucknell.edu/biology/resources/msw3/browse.asp?id=14000738 1. |

- |

3.3 Endnoten

Die Frage lautet:

Wo finde ich weitere Informationen zum Dingo als Unterart von...?

Erkannt werden muss der Zusammenhang zwischen Text und den Endnoten.

Ergebnis:

|

RAG |

Beurteilung |

Text |

Link |

Anmerkungen |

|

|

falsch |

Der Dingo wird als Haushund betrachtet, jedoch provisorisch als eigenständige Unterart des Wolfes geführt |

- |

|

|

MD |

richtig |

Weitere Informationen zum Dingo als Unterart des Wolfes finden Sie in der Quelle von W. Christopher Wozencraft: "Order Carnivora" in "Mammal Species of the World: A Taxonomic and Geographic Reference". Der Dingo wird dort provisorisch als eigenständige Unterart des Wolfes geführt |

- |

|

|

HTML |

richtig |

Weitere Informationen zum Dingo als Unterart des Wolfes finden Sie in der Quelle von W. Christopher Wozencraft: "Order Carnivora" in "Mammal Species of the World: A Taxonomic and Geographic Reference". Der Dingo wird dort provisorisch als eigenständige Unterart des Wolfes geführt |

- |

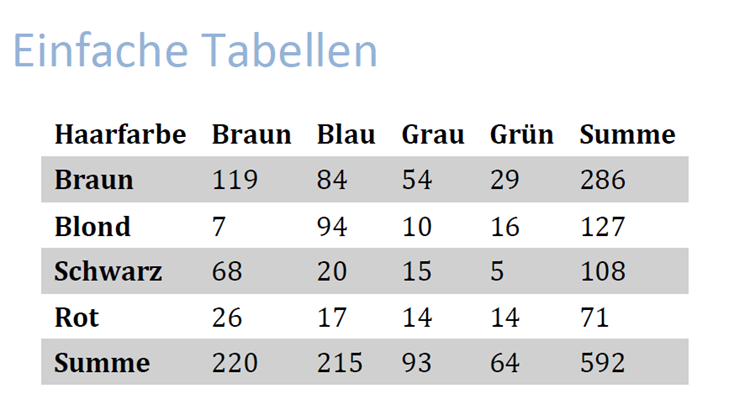

3.4 Tabellen

In diesem Teil der Studie wurde untersucht, ob einfache Tabellen korrekt erfasst werden, bevor komplexere Tabellen mit zusätzlichen Strukturen betrachtet werden. Die einfache Tabelle hatte einen klaren 6×6-Aufbau ohne Überspannungen. Um Missverständnisse bei der Abfrage zu vermeiden, enthielt sie ausschließlich Zahlenwerte als Inhalte sowie eindeutige Überschriften für jede Zeile und Spalte. Die Abfrage erfolgte durch die Kombination der jeweiligen Zeilen- und Spaltenüberschriften, sodass eine eindeutige Identifizierung der Werte gewährleistet war.

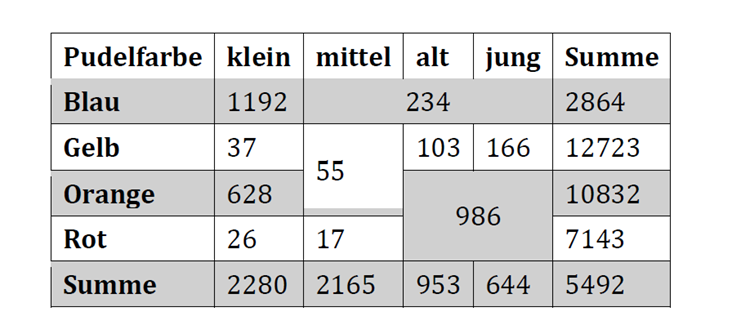

Bei den komplexeren Tabellen wurden gezielt Überspannungen eingeführt, die über mehrere Spalten oder Zeilen reichten. Diese strukturellen Besonderheiten mussten berücksichtigt werden, um die korrekten Antworten zu ermitteln. Die Studie untersuchte, inwiefern sich diese zusätzlichen Herausforderungen auf die Erfassungsgenauigkeit auswirkten und ob die drei RAG-Systeme die komplexen Tabellen ebenso zuverlässig interpretieren konnten wie die einfachen.

Die Frage lautet:

Nenne den Wert bei der Haarfarbe bei der Kombination aus Schwarz und Grün

Erkannt werden muss der Zusammenhang zwischen Spalten und Zeilen und die jeweiligen Überschriften.

Ergebnis:

|

RAG |

Beurteilung |

Text |

Link |

Anmerkungen |

|

|

richtig |

Der Wert bei der Haarfarbe für die Kombination aus Schwarz und Grün beträgt 5 |

- |

|

|

MD |

richtig |

Der Wert bei der Haarfarbe für die Kombination aus Schwarz und Grün beträgt 5 |

- |

|

|

HTML |

richtig |

Der Wert bei der Haarfarbe für die Kombination aus Schwarz und Grün beträgt 5 |

- |

Die Frage lautet:

Nenne den Wert bei der Pudelfarbe bei der Kombination aus Rot und jung

Erkannt werden muss der Zusammenhang zwischen Spalten und Zeilen unter Berücksichtigung der Überspannungen und die jeweiligen Überschriften.

Ergebnis:

|

RAG |

Beurteilung |

Text |

Link |

Anmerkungen |

|

|

falsch |

Der Wert bei der Pudelfarbe in der Kombination aus Rot und jung beträgt 17 |

- |

|

|

MD |

richtig |

Der Wert bei der Pudelfarbe in der Kombination aus Rot und jung beträgt 986 |

- |

|

|

HTML |

falsch |

Der Wert bei der Pudelfarbe für die Kombination aus Rot und jung beträgt 14 |

- |

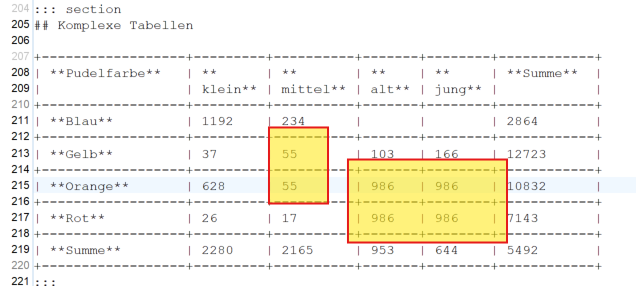

Unterschiede in der Abfrage von HTML- und Markdown-Dateien

Auffällig ist, dass die Abfrage der HTML-Datei nicht korrekt funktionierte, während die Markdown-Datei problemlos verarbeitet wurde. Eine mögliche Ursache für das Problem mit der HTML-Datei könnte darin liegen, dass entweder alle Attribute oder sogar sämtliche Tags ignoriert wurden. Dies hätte zur Folge, dass Tabellenstrukturen mit Überspannungen nicht richtig erkannt werden, was zu fehlerhaften oder unvollständigen Abfragen führt.

Im Gegensatz dazu funktionierte die Markdown-Datei, da beim Erzeugen des Markdown-Codes die Überspannungen aufgelöst wurden. Dadurch war die Struktur für die Abfrage klarer und einfacher interpretierbar.

In der folgenden Abbildung wird der verwendete Markdown-Code dargestellt:

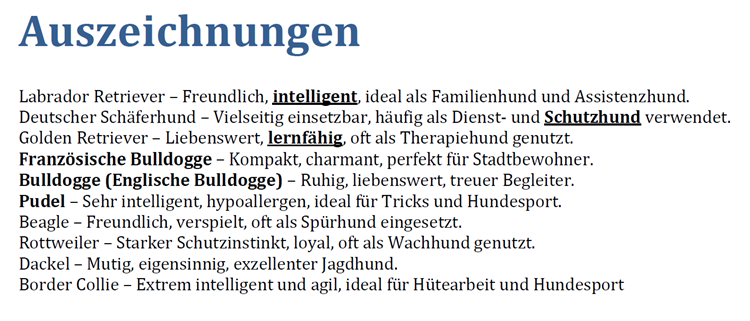

3.5 Auszeichnungen

Einfluss von Textformatierungen auf die Identifikation wichtiger Eigenschaften

In unserem Experiment haben wir einen Text vorgegeben, in dem bestimmte Wörter aus einer definierten Liste durch fett und unterstrichen hervorgehoben wurden. Die Fragestellung war so formuliert, dass ein Mensch mit hoher Wahrscheinlichkeit diese hervorgehobenen Begriffe als die zentralen Eigenschaften der Liste identifizieren würde.

Die Ergebnisse zeigten jedoch, dass unabhängig vom gewählten Format – sei es Fett, Unterstreichung oder eine Kombination – die Formatierung keinen Einfluss auf die Generierung der Antwort hatte. In weiteren Tests wurden sogar H1-Elemente verwendet, um wichtige Begriffe noch stärker hervorzuheben. Auch hier zeigte sich kein Effekt.

Stattdessen erwies sich die Nähe der Begriffe im Text als entscheidender Faktor. Das bedeutet, dass nicht die visuelle oder strukturelle Hervorhebung, sondern die relative Position der Begriffe innerhalb des Textes maßgeblich beeinflusst, welche Informationen als relevant erkannt und in die Antwort übernommen werden.

Die Frage hier lautet:

Nenne die wichtigste Eigenschaft eines Deutscher Schäferhundes. Nenne nur eine.

Erkannt werden muss der Zusammenhang zwischen Auszeichnung als semantische Betonung im Text und der Wichtigkeit dieser.

Ergebnis:

|

RAG |

Beurteilung |

Text |

Link |

Anmerkungen |

|

|

falsch |

Vielseitigkeit |

- |

|

|

MD |

falsch |

Vielseitigkeit |

- |

|

|

HTML |

falsch |

Vielseitigkeit |

- |

3.6 Layout

Einfluss des Layouts auf die Texterkennung

Hier wurden drei verschiedene Layout-Ansätze getestet, um zu analysieren, wie gut die Verarbeitung und Interpretation durch Retrieval-Augmented Generation (RAG) funktioniert.

-

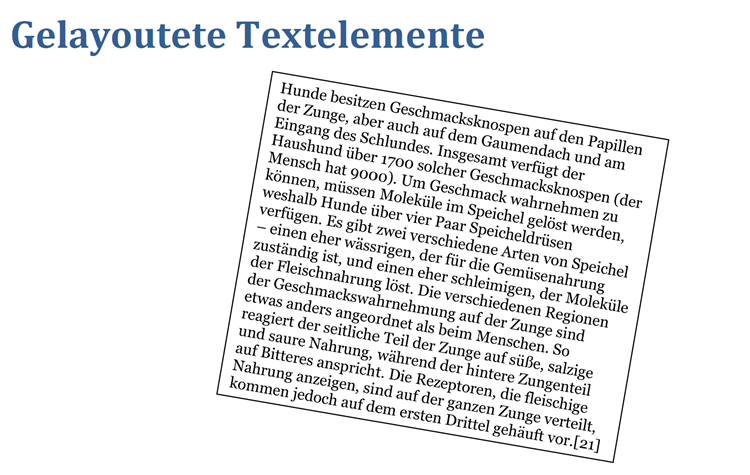

Gedrehter Text in einer Textbox

Hier wurde ein Text in einer Textbox platziert und um einige Grad gedreht. -

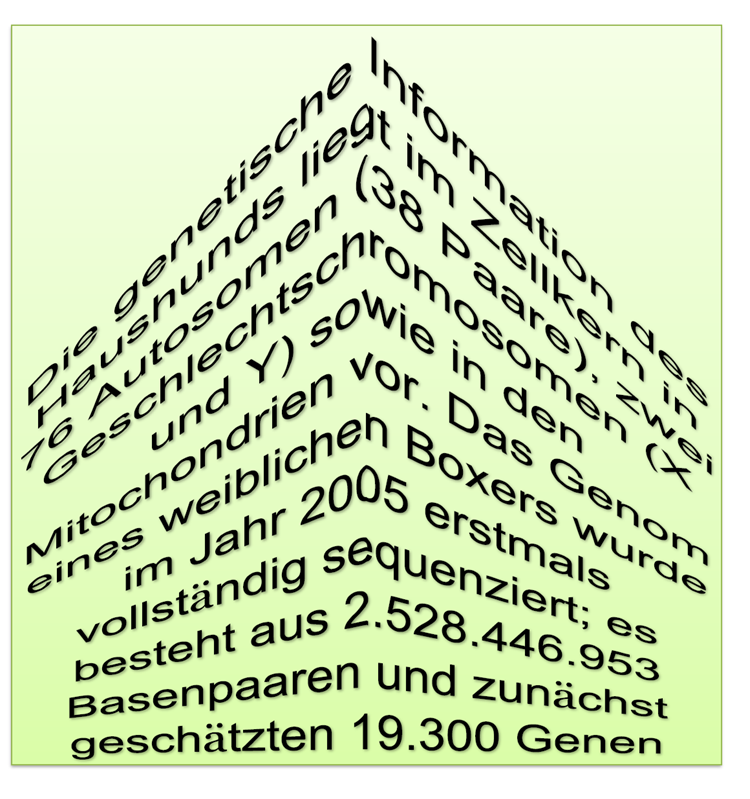

Stark verzerrter Text

Der Text wurde so verändert, dass er optisch stark verzerrt erschien. -

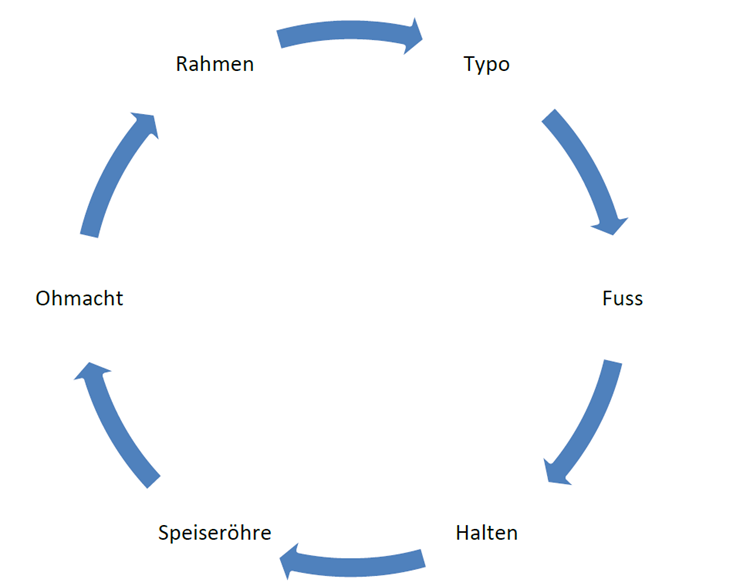

Schaubild mit Pfeilen zur Darstellung einer Reihenfolge

Ein Diagramm mit Pfeilen sollte eine logische Reihenfolge visualisieren.

Die Ergebnisse zeigten, dass die zweite Variante – der stark verzerrte Text – in allen Formaten korrekt verarbeitet wurde. Die erste und die dritte Variante hingegen funktionierten bei PDFs nicht, während sie bei HTML- und Markdown-Dateien erfolgreich verarbeitet wurden.

Beim Schaubild ist davon auszugehen, dass die PDF-zu-Text-Umwandlung der horizontalen Position der Inhalte Vorrang gab und die Pfeile als strukturgebendes Element ignoriert wurden. Dadurch ging die intendierte Reihenfolge der Informationen verloren, was zu einer fehlerhaften Interpretation führte.

Beim gedrehten Text könnte die fehlende Erkennung des eigentlichen Textflusses durch die PDF-zu-Text-Umwandlung dazu geführt haben, dass die Zeichen in einer falschen Reihenfolge extrahiert wurden. Dies hätte dann zu einem unverständlichen Kauderwelsch geführt, anstatt den Text sinnvoll wiederzugeben.

Die Frage hier lautet:

Hunde besitzen wieviele Geschmacksknospen? und wieviele im Vergleich dazu der Mensch?

Erkannt werden muss der bei der PDF-zu-Textumwandlung der Textfluss. Die anderen Formate haben den Text in lesbarer Form

Ergebnis:

|

RAG |

Beurteilung |

Text |

Link |

Anmerkungen |

|

|

falsch |

keine Ahnung. Habe dazu keine Informationen. |

- |

|

|

MD |

richtig |

Hunde besitzen insgesamt 1700 Geschmacksknospen. Im Vergleich dazu hat der Mensch 9000 Geschmacksknospen |

- |

|

|

HTML |

richtig |

Hunde besitzen insgesamt 1700 Geschmacksknospen. Im Vergleich dazu hat der Mensch 9000 Geschmacksknospen |

- |

Die Frage hier lautet:

Wie viele Autosomen hat der Zellkern des Hundes?

Erkannt werden muss der bei der PDF zu Textumwandlung der Textfluss. Die anderen Formate haben den Text in lesbarer Form

Ergebnis:

|

RAG |

Beurteilung |

Text |

Link |

Anmerkungen |

|

|

richtig |

Der Zellkern des Hundes enthält 76 Autosomen (38 Paare). |

- |

|

|

MD |

richtig |

Der Zellkern des Hundes enthält 76 Autosomen (38 Paare). |

- |

|

|

HTML |

richtig |

Der Zellkern des Hundes enthält 76 Autosomen (38 Paare). |

- |

Die Frage hier lautet:

Ordne die folgenden Begriffe: Ohmacht, Speiseröhre ,Fuss, Halten , Rahmen, Typo.

Erkannt werden muss die Reihenfolge, die durch die Pfeile dargestellt wird.

Ergebnis:

|

RAG |

Beurteilung |

Text |

Link |

Anmerkungen |

|

|

falsch |

Die Begriffe können alphabetisch wie folgt geordnet werden: Fuss Halten Ohmacht Rahmen Speiseröhre Typo |

- |

|

|

MD |

richtig |

Die Begriffe können in der Reihenfolge aus meiner Wissensbasis geordnet werden: Typo, Fuss, Halten, Speiseröhre, Ohmacht, Rahmen |

- |

|

|

HTML |

richtig |

Die Begriffe können in der Reihenfolge aus meiner Wissensbasis geordnet werden: Typo, Fuss, Halten, Speiseröhre, Ohmacht, Rahmen |

- |

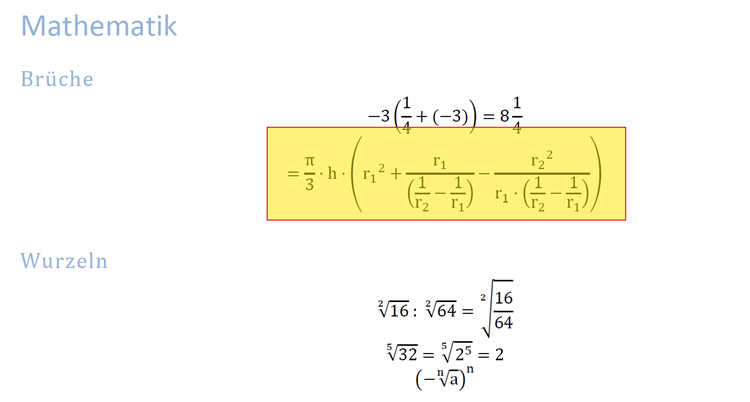

3.7 Semantik Mathematik

Die Frage hier lautet:

Gibt es Formeln mit dem Radius r2

Erkannt werden muss die Semantik der Formel.

Ergebnis:

Die Antwort aller drei Agents war:

Ja, in meinem Wissen gibt es eine Formel, die den Radius ( r_2 ) enthält:

[

= \frac{\pi}{3} \cdot h \cdot \left( {r_{1}}^{2} + \frac{r_{1}}{\left( \frac{1}{r_{2}} - \frac{1}{r_{1}} \right)} - \frac{{r_{2}}^{2}}{r_{1} \cdot \left( \frac{1}{r_{2}} - \frac{1}{r_{1}} \right)} \right)

]

Die Antwort wurde als korrekt gewertet, weil dies die Repräsentanz der TeXformel ist. Es handelt sich hier also um ein Problem in der Darstellung nicht in der Erfassung und Beantwortung.

|

RAG |

Beurteilung |

Text |

Link |

Anmerkungen |

|

|

richtig |

Siehe Bild |

- |

|

|

MD |

richtig |

Siehe Bild |

- |

|

|

HTML |

richtig |

Siehe Bild |

- |

3.8 Index

Indexeinträge stellen eine besondere Herausforderung für die PDF-zu-Text-Konvertierung dar. Sie enthalten meist nur eine Seitenzahl, die sich auf die Paginierung bezieht – nicht unbedingt auf die tatsächliche Seitenzählung im PDF. Zudem kann die Paginierung in verschiedenen Formaten vorliegen (z. B. römische oder arabische Ziffern), was die Zuordnung erschwert.

Ein weiteres Problem ist, dass die Fundstelle eines Indexeintrags im Fließtext nicht in jedem Fall identisch mit dem eigentlichen Indexeintrag ist. Im Beispieldokument taucht das Stichwort „Eckeltier“ im Fließtext gar nicht auf, es wurde als Indexeintrag mit der Fundstelle „Straßenhunde“ verknüpft. In der Datenbasis PDF gehen dadurch wertvolle semantische Informationen verloren.

Im Gegensatz dazu sind Indexeinträge und Marginalien in HTML oder überarbeitetem Markdown direkt im Fließtext verankert, wodurch sie leichter identifiziert und weiterverarbeitet werden können. Gerade für eine tiefere semantische Erschließung von Texten sind diese Strukturen essenziell, da sie Zusammenhänge und Querverweise herstellen.

Die Frage hier lautet:

Welche Hunde werden als Ekeltiere bezeichnet

Erkannt werden muss die Zuordnung im Index.

Ergebnis:

|

RAG |

Beurteilung |

Text |

Link |

Anmerkungen |

|

|

falsch |

Keine Ahnung. Habe dazu keine Informationen. |

- |

|

|

MD |

richtig |

Straßenhunde werden in einigen Kontexten als "Ekeltier" bezeichnet, insbesondere wenn sie aufgrund inadäquater Nahrung ständigen Mangelzuständen ausgesetzt sind |

- |

|

|

HTML |

richtig |

Straßenhunde werden in einigen Kontexten als "Ekeltier" bezeichnet, insbesondere wenn sie aufgrund inadäquater Nahrung ständigen Mangelzuständen ausgesetzt sind |

- |

4 Diskussion

4.1 Ablauf eines RAG-Trainings

Die Datenextraktion & Bereinigung sowie die Berechnung & Speicherung der Embeddings sind die beiden entscheidenden Schritte beim Training eines RAG-Modells. Hier besteht noch die Möglichkeit, die Qualität der verarbeiteten Inhalte gezielt zu beeinflussen, um bessere Retrieval- und Generierungsergebnisse zu erzielen.

4.1.1 Datenextraktion & Bereinigung

Zuerst müssen unstrukturierte Daten in ein einheitliches Textformat umgewandelt werden. PDFs können mit pdfplumber oder PyMuPDF extrahiert werden, während Webseiten mit BeautifulSoup gecrawlt werden. Daten aus Datenbanken lassen sich über SQL-Abfragen oder APIs abrufen.

Nach der Extraktion wird der Text segmentiert – entweder in Sätze, Absätze oder thematische Einheiten. Dies hilft, kleinere und präzisere Informationsblöcke für das Retrieval zu erzeugen. Anschließend erfolgt eine Bereinigung, bei der überflüssige Leerzeichen, HTML-Tags oder Sonderzeichen entfernt werden.

Um die semantische Qualität der Daten zu verbessern, können Metadaten wie Titel, Autor, Datum oder Kategorien integriert werden. Diese helfen später bei der semantischen Suche und der besseren Kontextgewichtung.

4.1.2 Embeddings berechnen & speichern

Die verarbeiteten Textsegmente werden in Vektor-Repräsentationen umgewandelt. Dafür können vortrainierte Modelle wie sentence-transformers (all-MiniLM, BGE, E5) genutzt oder mit kontrastivem Lernen für spezifische Domänen feinjustiert werden.

Um semantische Zusammenhänge besser abzubilden, können separate Embeddings für Metadaten und Inhalt erzeugt und kombiniert werden. Alternativ können spezielle Tags ([TITLE], [DATE]) eingefügt werden, um das Modell auf unterschiedliche Kontexte zu sensibilisieren.

Die berechneten Embeddings werden anschließend in einer Vektordatenbank wie FAISS, Pinecone oder ChromaDB gespeichert. Dadurch lassen sich Texte effizient durchsuchen und abrufen.

4.2 Kritische Sicht auf die Studie

Die Studie war in gewisser Weise nicht ganz fair, da sie exemplarisch aufzeigte, wie die Qualität der Antworten je nach definiertem Problem stark variieren kann. Dabei wurden jedoch nicht verschiedene methodische Ansätze betrachtet oder mehrere fertige Systeme miteinander verglichen, was eine umfassendere Bewertung ermöglicht hätte.

Zudem verfügen wir durch unseren Octopus-Service über eine umfassende Expertise in der Umwandlung von PDF zu XML und wissen genau, wie die Datenextraktion in der Praxis üblicherweise abläuft. Gerade hier liegt der größte Hebel, denn wenn bereits in diesem frühen Schritt Informationen verloren gehen oder nicht korrekt erfasst werden, ist eine nachträgliche Korrektur kaum noch möglich. Shit in, shit out – selbst das beste System kann nur so gute Ergebnisse liefern, wie es die Qualität der zugrunde liegenden Daten erlaubt.

5 Schlussfolgerungen

Die Studie hat klar gezeigt, dass eine strukturierte Datei deutlich bessere Ergebnisse beim Training eines RAG-Modells liefert als eine nicht strukturierte. Besonders in wissenschaftlichen und juristischen Kontexten sind Verknüpfungen, Literaturverzeichnisse und Fußnoten von entscheidender Bedeutung. Diese Elemente tragen maßgeblich zum Verständnis und zur korrekten Kontextualisierung der Informationen bei. Eine Verarbeitung ohne diese Dokumentteile einzubeziehen wäre daher nicht zielführend, da wichtige semantische Beziehungen und Quellenangaben verloren gehen würden.

Tabellen sind ebenfalls von großer Bedeutung, da sie häufig strukturierte und entscheidende Daten enthalten. In vielen Fällen spielen sie eine zentrale Rolle beim Verständnis und der Extraktion von Informationen. Gerade hier ist das Verstehen der Daten von entscheidender Bedeutung, um die richtigen Zusammenhänge zu erkennen und die Informationen korrekt zu extrahieren.

Insgesamt zeigt die Studie, dass eine strukturierte Datenbasis, die alle relevanten Teile wie Fußnoten, Verknüpfungen und Tabellen berücksichtigt, unerlässlich ist, um qualitativ hochwertige Ergebnisse aus einem RAG-Modell zu erzielen.

Die Testsuite, die im Rahmen dieser Studie erstellt wurde, ermöglicht nun den Vergleich verschiedener RAG-Systemanbieter und Embeddings. Mit den bereitgestellten Trainingsdateien und der Reihe von Prompts können die Systeme getestet und ihre Antworten sowie Bewertungen miteinander verglichen werden, um die Leistungsfähigkeit der verschiedenen Ansätze zu evaluieren.

Die Studie stellt dennoch nur einen ersten Schritt dar, der wichtige Grundlagen für die weitere Entwicklung legt. In Teil II der Studienreihe werden Embedding-Modelle einbezogen, um zu analysieren, wie Semantik in diesen Modellen abgelegt und genutzt werden kann.

Ein wesentliches Ziel wird es sein, ein strukturiertes Zwischenformat zu entwickeln, aus dem verschiedene Modelle effizient beliefert werden können. Dadurch sollen eine bessere Konsistenz und Qualität der Daten sichergestellt werden. Ein weiterer Fokus liegt darauf, mit unserem Octopus-Service aus PDFs und anderen Formaten möglichst viele Daten vollautomatisch zu extrahieren und dabei deutlich mehr Semantik bereitzustellen als in aktuellen Systemen üblich. So soll eine präzisere und kontextreichere Verarbeitung ermöglicht werden, die über die reine Textextraktion hinausgeht (siehe Teil III der Studienreihe).

Teil IV der Studienreihe wird sich schließlich mit der Datenhaltung und der Implementierung von Content-Delivery-Services befassen, um zu optimieren, wie semantische Daten effizient gespeichert, abgerufen und in verschiedene Anwendungen integriert werden können.

6 Anhang

Der Ordner enthält drei Dateiformate (HTML, Markdown, PDF), die denselben Inhalt wiedergeben. Eine Excel-Datei Ergebnisse_Zusammenfassung.xlsx fasst alle Ergebnisse, Prompts, Antworten und Bewertungen zusammen.